Tại GTC 2025, Huang Renxun đã tiết lộ một thông tin cực kỳ quan trọng, NVIDIA sẽ đầu tư 1 tỷ USD vào Nokia. Đúng vậy, chính là công ty điện thoại Symbian Nokia từng nổi tiếng khắp nơi cách đây 20 năm.

Trong bài phát biểu, Huang Renxun cho biết mạng viễn thông đang trải qua một sự chuyển đổi lớn từ kiến trúc truyền thống sang hệ thống gốc AI, và khoản đầu tư của NVIDIA sẽ thúc đẩy quá trình này. Vì vậy, NVIDIA đã chọn hình thức đầu tư để cùng Nokia xây dựng một nền tảng AI hướng tới mạng 6G, đưa AI vào mạng RAN truyền thống.

Hình thức đầu tư cụ thể là NVIDIA sẽ đăng ký mua khoảng 166 triệu cổ phiếu mới của Nokia với giá 6,01 USD/cổ phiếu, qua đó NVIDIA sẽ nắm giữ khoảng 2,9% cổ phần của Nokia.

Ngay khi thông báo hợp tác được đưa ra, giá cổ phiếu Nokia đã tăng 21%, mức tăng lớn nhất kể từ năm 2013.

01 AI-RAN là gì?

RAN là mạng truy cập vô tuyến, còn AI-RAN là kiến trúc mạng mới tích hợp trực tiếp khả năng tính toán AI vào các trạm gốc vô tuyến. Hệ thống RAN truyền thống chủ yếu chịu trách nhiệm truyền dữ liệu giữa trạm gốc và thiết bị di động, còn AI-RAN bổ sung thêm chức năng tính toán biên và xử lý thông minh.

Điều này cho phép trạm gốc áp dụng các thuật toán AI để tối ưu hóa việc sử dụng phổ tần và hiệu suất năng lượng, cải thiện hiệu suất tổng thể của mạng, đồng thời tận dụng tài sản RAN nhàn rỗi để lưu trữ các dịch vụ AI biên, tạo ra nguồn thu mới cho nhà mạng.

Nhà mạng có thể chạy ứng dụng AI trực tiếp tại trạm gốc, mà không cần gửi toàn bộ dữ liệu về trung tâm dữ liệu để xử lý, giúp giảm đáng kể gánh nặng cho mạng lưới.

Huang Renxun lấy ví dụ, gần 50% người dùng ChatGPT truy cập qua thiết bị di động, hơn nữa, số lượt tải ChatGPT trên di động hàng tháng đã vượt 40 triệu. Trong thời đại AI phát triển bùng nổ, hệ thống RAN truyền thống không thể đáp ứng được các ứng dụng AI sinh thành và mạng di động do các agent thông minh chi phối.

AI-RAN, nhờ khả năng suy luận AI phân tán tại biên, giúp các ứng dụng AI tiếp theo như agent, chatbot phản hồi nhanh hơn. Đồng thời, AI-RAN cũng chuẩn bị cho các ứng dụng tích hợp cảm biến và truyền thông trong kỷ nguyên 6G.

Huang Renxun trích dẫn dự báo của công ty phân tích Omdia, công ty này dự đoán thị trường RAN sẽ đạt tổng cộng hơn 200 tỷ USD vào năm 2030, trong đó AI-RAN sẽ là phân khúc tăng trưởng nhanh nhất.

Chủ tịch kiêm CEO Nokia, Justin Hottard, cho biết trong tuyên bố chung rằng quan hệ đối tác này sẽ đưa trung tâm dữ liệu AI vào túi của mọi người, hiện thực hóa việc tái thiết kế căn bản từ 5G lên 6G.

Ông đặc biệt nhấn mạnh Nokia đang hợp tác với ba doanh nghiệp khác nhau: NVIDIA, Dell và T-Mobile. T-Mobile là đối tác đầu tiên sẽ bắt đầu thử nghiệm thực địa công nghệ AI-RAN từ năm 2026, tập trung xác minh hiệu suất và hiệu quả. Justin cho biết thử nghiệm này sẽ cung cấp dữ liệu quý giá cho đổi mới 6G, giúp nhà mạng xây dựng mạng thông minh đáp ứng nhu cầu AI.

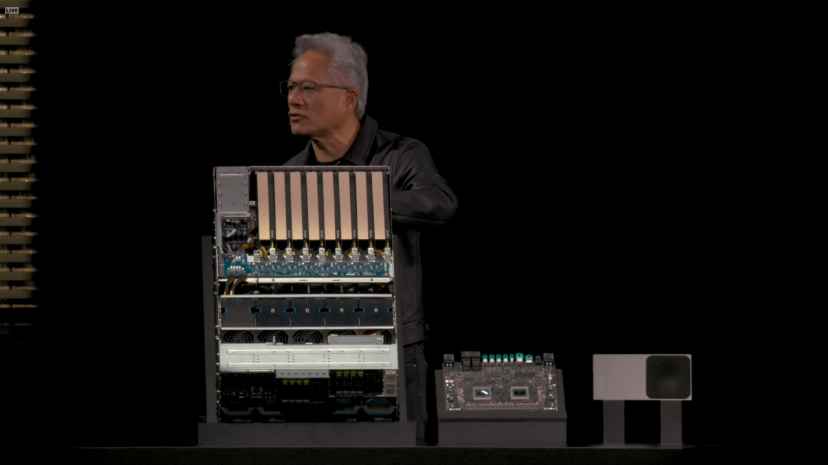

Dựa trên AI-RAN, sản phẩm mới mà NVIDIA ra mắt có tên là Aerial RAN Computer Pro (ARC-Pro), đây là nền tảng tính toán tăng tốc chuẩn bị cho 6G. Cấu hình phần cứng cốt lõi của nó bao gồm cả hai loại GPU của NVIDIA: Grace CPU và Blackwell GPU.

Nền tảng này chạy trên NVIDIA CUDA, phần mềm RAN có thể tích hợp trực tiếp vào ngăn xếp công nghệ CUDA. Do đó, nó không chỉ xử lý các chức năng truyền thống của mạng truy cập vô tuyến mà còn có thể chạy đồng thời các ứng dụng AI phổ biến. Đây cũng là phương pháp cốt lõi để NVIDIA hiện thực hóa hai chữ AI trong AI-RAN.

Với lịch sử lâu đời của CUDA, lợi thế lớn nhất của nền tảng này chính là khả năng lập trình. Không chỉ vậy, Huang Renxun còn công bố sẽ mã nguồn mở khung phần mềm Aerial, dự kiến phát hành trên GitHub với giấy phép Apache 2.0 từ tháng 12/2025.

Khác biệt chính giữa ARC-Pro và sản phẩm tiền nhiệm ARC là vị trí triển khai và kịch bản ứng dụng. ARC thế hệ trước chủ yếu dùng cho triển khai RAN đám mây tập trung, còn ARC-Pro có thể triển khai trực tiếp tại trạm gốc, giúp năng lực tính toán biên thực sự được hiện thực hóa.

Người đứng đầu mảng viễn thông của NVIDIA, Ronnie Wahita, cho biết trước đây RAN và AI cần hai bộ phần cứng khác nhau, nhưng ARC-Pro có thể phân bổ tài nguyên tính toán động theo nhu cầu mạng, vừa ưu tiên xử lý chức năng truy cập vô tuyến, vừa có thể chạy nhiệm vụ suy luận AI khi nhàn rỗi.

ARC-Pro còn tích hợp nền tảng NVIDIA AI Aerial, đây là một bộ phần mềm hoàn chỉnh bao gồm phần mềm RAN tăng tốc CUDA, công cụ bản sao số Aerial Omniverse và khung Aerial Framework mới. Aerial Framework có thể chuyển đổi mã Python thành mã CUDA hiệu suất cao để chạy trên nền tảng ARC-Pro. Ngoài ra, nền tảng còn hỗ trợ các mô hình mạng thần kinh do AI điều khiển, dùng cho ước lượng kênh nâng cao.

Huang Renxun nói, viễn thông là hệ thần kinh số của kinh tế và an ninh. Hợp tác với Nokia và hệ sinh thái viễn thông sẽ thắp sáng cuộc cách mạng này, giúp nhà mạng xây dựng mạng thông minh, thích ứng, định nghĩa kết nối toàn cầu thế hệ tiếp theo.

02 Nhìn về năm 2025, NVIDIA thực sự đã đầu tư rất nhiều tiền.

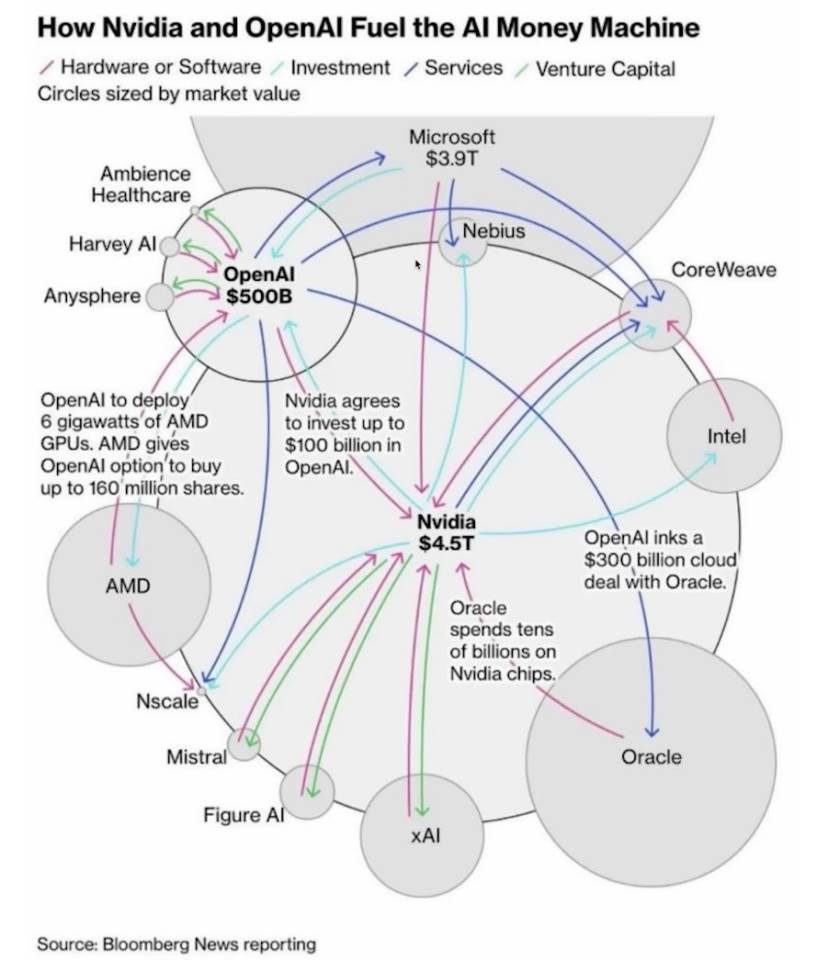

Ngày 22/9, NVIDIA và OpenAI đạt được thỏa thuận hợp tác, NVIDIA dự kiến sẽ đầu tư dần 100 tỷ USD vào OpenAI, thúc đẩy xây dựng hạ tầng của họ.

Huang Renxun cho biết thực ra OpenAI đã tìm kiếm đầu tư từ NVIDIA từ lâu, nhưng khi đó công ty còn hạn chế về tài chính. Ông hài hước nói, lúc đó quá nghèo, lẽ ra nên đưa hết tiền cho họ.

Huang Renxun cho rằng tăng trưởng suy luận AI không phải là 100 lần hay 1.000 lần, mà là 1 tỷ lần. Và sự hợp tác này không chỉ giới hạn ở phần cứng, mà còn bao gồm tối ưu hóa phần mềm, đảm bảo OpenAI có thể tận dụng hiệu quả hệ thống của NVIDIA.

Điều này có thể do ông biết được OpenAI hợp tác với AMD, lo ngại OpenAI sẽ bỏ CUDA. Nếu mô hình AI nền tảng lớn nhất thế giới không dùng CUDA, các nhà cung cấp mô hình lớn khác noi theo OpenAI cũng là điều dễ hiểu.

Trong podcast BG2, Huang Renxun dự đoán OpenAI rất có thể sẽ trở thành công ty tiếp theo đạt giá trị vốn hóa 1 nghìn tỷ USD, tốc độ tăng trưởng sẽ lập kỷ lục ngành. Ông bác bỏ quan điểm về “bong bóng AI”, chỉ ra rằng chi tiêu vốn cho hạ tầng AI toàn cầu mỗi năm sẽ đạt 5 nghìn tỷ USD.

Chính nhờ khoản đầu tư này, OpenAI đã công bố hoàn tất tái cấu trúc vốn vào ngày 29/10. Công ty được chia thành hai phần, một phần là quỹ phi lợi nhuận, phần còn lại là công ty vì lợi nhuận.

Quỹ phi lợi nhuận sẽ kiểm soát về mặt pháp lý phần vì lợi nhuận, đồng thời phải cân bằng lợi ích công cộng. Tuy nhiên, vẫn có thể tự do huy động vốn hoặc mua lại công ty. Quỹ sẽ sở hữu 26% cổ phần của công ty vì lợi nhuận và nắm giữ một quyền chọn mua cổ phiếu. Nếu công ty tiếp tục phát triển, quỹ còn có thể nhận thêm cổ phần.

Ngoài OpenAI, NVIDIA còn đầu tư vào xAI của Elon Musk trong năm 2025. Vòng gọi vốn hiện tại của công ty này đã tăng lên 20 tỷ USD. Trong đó khoảng 7,5 tỷ USD huy động qua cổ phần, tối đa 12,5 tỷ USD qua trái phiếu của thực thể mục đích đặc biệt (SPV).

Thực thể mục đích đặc biệt này sẽ dùng số tiền huy động được để mua bộ xử lý hiệu suất cao của NVIDIA, sau đó cho xAI thuê lại.

Những bộ xử lý này sẽ được sử dụng cho dự án Colossus 2 của xAI. Colossus thế hệ đầu là trung tâm dữ liệu siêu máy tính của xAI tại Memphis, Tennessee. Dự án Colossus đầu tiên đã triển khai 100.000 GPU H100 của NVIDIA, trở thành một trong những cụm huấn luyện AI lớn nhất thế giới. Hiện tại, xAI đang xây dựng Colossus 2, dự kiến mở rộng số lượng GPU lên hàng trăm nghìn hoặc nhiều hơn nữa.

Ngày 18/9, NVIDIA còn công bố sẽ đầu tư 5 tỷ USD vào Intel và thiết lập quan hệ hợp tác chiến lược sâu rộng. NVIDIA sẽ đăng ký mua cổ phiếu phổ thông mới phát hành của Intel với giá 23,28 USD/cổ phiếu, tổng giá trị đầu tư đạt 5 tỷ USD. Sau giao dịch, NVIDIA sẽ nắm giữ khoảng 4% cổ phần của Intel, trở thành nhà đầu tư chiến lược quan trọng.

03 Tất nhiên, tại GTC lần này Huang Renxun còn nói rất nhiều điều khác.

Ví dụ NVIDIA đã ra mắt nhiều dòng mô hình AI mã nguồn mở, bao gồm Nemotron cho AI số, Cosmos cho AI vật lý, Isaac GR00T cho robot và Clara cho AI y sinh.

Đồng thời, Huang Renxun đã ra mắt nền tảng phát triển lái xe tự động DRIVE AGX Hyperion 10. Đây là nền tảng hướng tới lái xe tự động cấp độ 4, tích hợp chip tính toán NVIDIA và bộ cảm biến đầy đủ, bao gồm lidar, camera và radar.

NVIDIA còn ra mắt chương trình chứng nhận Halos, đây là hệ thống đầu tiên trong ngành dùng để đánh giá và chứng nhận an toàn AI vật lý, chuyên biệt cho xe tự lái và công nghệ robot.

Lõi của chương trình chứng nhận Halos là hệ thống Halos AI, đây là phòng thí nghiệm đầu tiên trong ngành được Ủy ban Chứng nhận ANSI công nhận. ANSI là Viện Tiêu chuẩn Quốc gia Hoa Kỳ, chứng nhận của họ có uy tín và sức ảnh hưởng rất lớn.

Nhiệm vụ của hệ thống này là sử dụng AI vật lý của NVIDIA để kiểm tra xem hệ thống lái xe tự động có đáp ứng tiêu chuẩn hay không. Các công ty như AUMOVIO, Bosch, Nuro và Wayve là những thành viên đầu tiên của phòng thí nghiệm kiểm nghiệm hệ thống Halos AI.

Để thúc đẩy lái xe tự động cấp độ 4, NVIDIA đã phát hành một bộ dữ liệu lái xe tự động đa phương thức từ 25 quốc gia, bao gồm 1.700 giờ dữ liệu từ camera, radar và lidar.

Huang Renxun cho biết giá trị của bộ dữ liệu này nằm ở sự đa dạng và quy mô, nó bao gồm nhiều điều kiện đường sá, quy tắc giao thông và văn hóa lái xe khác nhau, cung cấp nền tảng cho việc huấn luyện hệ thống lái xe tự động phổ quát hơn.

Tuy nhiên, tầm nhìn của Huang Renxun không chỉ dừng lại ở đây.

Ông đã công bố tại GTC một loạt hợp tác với các phòng thí nghiệm chính phủ Hoa Kỳ và các doanh nghiệp hàng đầu, mục tiêu là xây dựng hạ tầng AI cho nước Mỹ. Huang Renxun nói, chúng ta đang ở bình minh của cuộc cách mạng công nghiệp AI, điều này sẽ định hình tương lai của mọi ngành và mọi quốc gia.

Điểm nhấn của hợp tác lần này là với Bộ Năng lượng Hoa Kỳ. NVIDIA đang giúp Bộ Năng lượng xây dựng hai trung tâm siêu máy tính, một tại Phòng thí nghiệm Quốc gia Argonne, một tại Phòng thí nghiệm Quốc gia Los Alamos.

Phòng thí nghiệm Argonne sẽ nhận được một siêu máy tính tên là Solstice, hệ thống này trang bị 100.000 GPU Blackwell của NVIDIA. 100.000 GPU là một con số khổng lồ, đây sẽ là siêu máy tính AI lớn nhất từ trước đến nay của Bộ Năng lượng. Ngoài ra còn có hệ thống Equinox với 10.000 GPU Blackwell, dự kiến đưa vào sử dụng năm 2026. Hai hệ thống này cộng lại cung cấp hiệu suất tính toán AI lên tới 2.200 exaflops.

Giám đốc Phòng thí nghiệm Argonne, Paul Koons, cho biết các hệ thống này sẽ định nghĩa lại hiệu suất, khả năng mở rộng và tiềm năng khoa học. Họ sẽ sử dụng sức mạnh tính toán này để làm gì? Từ khoa học vật liệu đến mô hình khí hậu, từ tính toán lượng tử đến mô phỏng vũ khí hạt nhân, tất cả đều cần đến năng lực tính toán ở cấp độ này.

Bên cạnh các phòng thí nghiệm chính phủ, NVIDIA còn xây dựng một trung tâm nghiên cứu nhà máy AI tại Virginia. Điểm đặc biệt của trung tâm này là không chỉ là một trung tâm dữ liệu, mà còn là một phòng thí nghiệm thử nghiệm. NVIDIA sẽ thử nghiệm một thứ gọi là Omniverse DSX tại đây, đây là bản thiết kế cho việc xây dựng nhà máy AI cấp gigawatt.

Một trung tâm dữ liệu thông thường chỉ cần vài chục megawatt điện, còn gigawatt tương đương với sản lượng của một nhà máy điện hạt nhân quy mô vừa.

Lõi ý tưởng của bản thiết kế Omniverse DSX là biến nhà máy AI thành một hệ thống tự học. Các agent AI sẽ liên tục giám sát điện năng, làm mát và tải công việc, tự động điều chỉnh tham số để nâng cao hiệu quả. Ví dụ khi tải lưới điện cao, hệ thống có thể tự động giảm tiêu thụ điện hoặc chuyển sang dùng pin lưu trữ.

Quản lý thông minh như vậy là cực kỳ quan trọng với các cơ sở cấp gigawatt, bởi chi phí điện và làm mát sẽ là con số khổng lồ.

Tầm nhìn này rất lớn, Huang Renxun nói ông cần ba năm để hiện thực hóa. Thử nghiệm AI-RAN phải đến năm 2026 mới bắt đầu, xe tự lái dựa trên DRIVE AGX Hyperion 10 phải đến năm 2027 mới có thể lăn bánh, siêu máy tính của Bộ Năng lượng cũng phải đến năm 2027 mới đưa vào sử dụng.

NVIDIA nắm trong tay “át chủ bài” CUDA, kiểm soát tiêu chuẩn thực tế của tính toán AI. Từ huấn luyện đến suy luận, từ trung tâm dữ liệu đến thiết bị biên, từ lái xe tự động đến y sinh, GPU của NVIDIA có mặt ở khắp nơi. Những khoản đầu tư và hợp tác được công bố tại GTC lần này càng củng cố vị thế đó.