Nowy horyzont bezpieczeństwa AI: między-laboratoryjne testowanie na rzecz zjednoczenia branży

- Ilya Sutskever z OpenAI opowiada się za testowaniem międzylaboratoryjnym w celu wzmocnienia bezpieczeństwa AI w obliczu szybkiego rozwoju technologicznego i ryzyk w całej branży. - Przeglądarkowy pilot Claude od Anthropic uwidacznia wyzwania związane z bezpieczeństwem, takie jak ataki typu prompt injection, co skłania do wdrażania skuteczniejszych strategii łagodzących. - Badanie ujawnia słabe przestrzeganie dobrowolnych zobowiązań dotyczących bezpieczeństwa przez główne firmy AI, w tym Apple, co podważa skuteczność samoregulacji. - AI Safety Initiative od Cloud Security Alliance oferuje ramy i RiskRub.

Współzałożyciel OpenAI i członek zarządu, Ilya Sutskever, wezwał do wdrożenia testów międzylaboratoryjnych jako kluczowego środka zapewniającego bezpieczeństwo systemów sztucznej inteligencji (AI). Jego oświadczenie pojawia się w obliczu rosnących obaw związanych z ryzykiem wynikającym z postępu AI, a liderzy branży podkreślają potrzebę współpracy i ustandaryzowanych protokołów bezpieczeństwa. Apel Sutskevera o testy międzylaboratoryjne wpisuje się w szersze działania na rzecz wzmocnienia bezpieczeństwa AI i ograniczenia potencjalnych szkód, w miarę jak technologia ta rozwija się w szybkim tempie [1].

Konieczność takich wspólnych podejść podkreślają ostatnie wydarzenia związane z wdrażaniem i regulacją AI. Przykładowo, Anthropic, jeden z głównych graczy w sektorze AI, uruchomił program pilotażowy dla swojego asystenta AI, Claude, zaprojektowanego do działania bezpośrednio w przeglądarkach użytkowników. Inicjatywa ta, mająca na celu zwiększenie użyteczności AI poprzez integrację z podstawowymi cyfrowymi procesami pracy, uwypukliła również istotne wyzwania związane z bezpieczeństwem i ochroną agentów AI działających w przeglądarkach. Ataki typu prompt injection — w których złośliwi aktorzy manipulują zachowaniem AI poprzez ukryte instrukcje — stały się kluczowym zagrożeniem, co skłoniło Anthropic do wdrożenia solidnych strategii ograniczających, takich jak uprawnienia na poziomie witryny, potwierdzenia działań oraz zaawansowane klasyfikatory wykrywające podejrzane wzorce [2].

Tego typu ryzyka nie ograniczają się do pojedynczych firm. Ostatnie badania naukowców z Brown, Harvard i Stanford wykazały, że wiele firm AI nie wypełniło w pełni swoich dobrowolnych zobowiązań dotyczących bezpieczeństwa, zwłaszcza po zobowiązaniach dotyczących bezpieczeństwa AI złożonych przez administrację Bidena w 2023 roku. Apple, na przykład, wypadło słabo w tej ocenie — dowody na zgodność wykazano tylko dla jednego z ośmiu zobowiązań. Badanie to podkreśla ograniczenia samoregulacji w szybko rozwijającej się branży i rodzi pytania o skuteczność dobrowolnych środków w zapewnianiu odpowiedzialności i bezpieczeństwa [5].

W odpowiedzi na te wyzwania, Cloud Security Alliance (CSA) uruchomiło pod koniec 2023 roku inicjatywę AI Safety Initiative, skupiającą liderów branży, agencje rządowe i instytucje akademickie w celu opracowania praktycznych narzędzi i ram zarządzania ryzykiem AI. Inicjatywa ta dostarcza organizacjom listy kontrolne gotowości AI, ramy zarządzania oraz wytyczne dotyczące bezpieczeństwa, mając na celu dostosowanie postępu technologicznego do oczekiwań regulacyjnych. Warto zauważyć, że CSA wprowadziło również RiskRubric.ai — system oceniania, który ocenia bezpieczeństwo, przejrzystość i niezawodność dużych modeli językowych (LLM), oferując przedsiębiorstwom podejście oparte na danych do wdrażania AI [4].

Wspólne wysiłki na rzecz zwiększenia bezpieczeństwa AI są również wspierane przez rosnący ekosystem fundatorów i programów grantowych. Organizacje takie jak Long-Term Future Fund, Survival and Flourishing Fund oraz AI Safety Fund zapewniają wsparcie finansowe badaczom, przedsiębiorcom i instytucjom pracującym nad ograniczaniem ryzyka AI. Inicjatywy te mają na celu przeciwdziałanie długoterminowym egzystencjalnym zagrożeniom, a jednocześnie promowanie odpowiedzialnych innowacji. Dodatkowo, firmy venture capital takie jak Juniper Ventures i Mythos Ventures inwestują w startupy rozwijające narzędzia poprawiające bezpieczeństwo, zgodność i zarządzanie AI [6].

Apel o testy międzylaboratoryjne, popierany przez Sutskevera, stanowi kluczowy krok w kierunku rozwiązania tych systemowych wyzwań. Umożliwiając wspólne standardy i przejrzystą ocenę w laboratoriach rozwijających AI, branża może budować większe zaufanie i odpowiedzialność. Takie podejście jest szczególnie ważne, gdy systemy AI stają się coraz bardziej złożone i zaawansowane, co wymaga zjednoczonego frontu do oceny potencjalnych zagrożeń przed wdrożeniem. OpenAI, Anthropic i inni kluczowi interesariusze mają szansę — i odpowiedzialność — przewodzić tej transformacji poprzez przyjęcie wspólnych protokołów bezpieczeństwa i ustanowienie precedensu dla odpowiedzialnych innowacji w AI [1].

Zastrzeżenie: Treść tego artykułu odzwierciedla wyłącznie opinię autora i nie reprezentuje platformy w żadnym charakterze. Niniejszy artykuł nie ma służyć jako punkt odniesienia przy podejmowaniu decyzji inwestycyjnych.

Może Ci się również spodobać

Prawda o gospodarce: AI napędza wzrost, kryptowaluty stają się aktywami politycznymi

Artykuł analizuje obecną sytuację gospodarczą, wskazując, że AI jest głównym motorem wzrostu PKB, podczas gdy inne sektory, takie jak rynek pracy i finanse gospodarstw domowych, ulegają osłabieniu. Dynamika rynkowa oderwała się od fundamentów, a wydatki kapitałowe na AI stały się kluczowe dla uniknięcia recesji. Rosnące nierówności majątkowe oraz ograniczenia w dostawach energii stają się wąskimi gardłami dla rozwoju AI. W przyszłości AI i kryptowaluty mogą stać się priorytetem dla zmian politycznych. Streszczenie wygenerowane przez Mars AI. Model Mars AI jest wciąż udoskonalany w zakresie dokładności i kompletności generowanych treści.

Jednorożec AI Anthropic przyspiesza przygotowania do IPO, stawiając czoła OpenAI?

Anthropic przyspiesza ekspansję na rynku kapitałowym, rozpoczynając współpracę z czołowymi kancelariami prawnymi, co jest postrzegane jako ważny sygnał przygotowań do wejścia na giełdę. Wycena firmy zbliża się do 300 miliardów dolarów, a inwestorzy liczą, że uda jej się zadebiutować przed OpenAI.

Nawet prestiżowe uniwersytety popełniają błędy inwestycyjne? Tuż przed gwałtownym spadkiem ceny bitcoin, Harvard zainwestował 500 milionów dolarów.

Fundusz darowiznowy Uniwersytetu Harvarda w poprzednim kwartale znacznie zwiększył swoje udziały w bitcoin ETF do prawie 500 milionów dolarów, jednak w tym kwartale cena bitcoina spadła o ponad 20%, co naraża fundusz na znaczące ryzyko związane z wyborem momentu inwestycji.

Strukturalny wpływ następnego przewodniczącego Fed na branżę kryptowalut: zmiana polityki i przebudowa regulacji

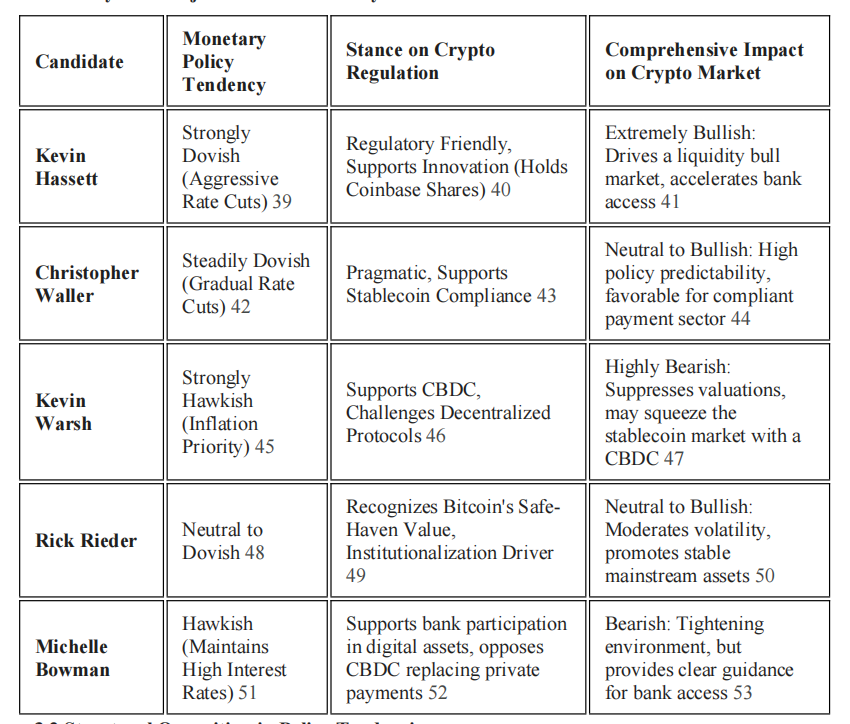

Zmiana na stanowisku przewodniczącego Rezerwy Federalnej będzie decydującym czynnikiem kształtującym przyszłe makroekonomiczne otoczenie dla branży kryptowalut.