Dalam upaya terbarunya untuk mengatasi kekhawatiran yang berkembang tentang dampak AI terhadap kaum muda, OpenAI pada hari Kamis memperbarui pedoman tentang bagaimana model AI-nya harus berperilaku dengan pengguna di bawah usia 18 tahun, dan menerbitkan sumber daya literasi AI baru untuk remaja dan orang tua. Namun, masih ada pertanyaan tentang seberapa konsisten kebijakan tersebut akan diterapkan dalam praktiknya.

Pembaruan ini hadir saat industri AI secara umum, dan OpenAI secara khusus, menghadapi peningkatan pengawasan dari pembuat kebijakan, pendidik, dan advokat keselamatan anak setelah beberapa remaja diduga meninggal karena bunuh diri setelah melakukan percakapan panjang dengan chatbot AI.

Gen Z, yang mencakup mereka yang lahir antara 1997 dan 2012, adalah pengguna chatbot OpenAI yang paling aktif. Dan setelah kesepakatan terbaru OpenAI dengan Disney, lebih banyak anak muda mungkin akan berbondong-bondong ke platform ini, yang memungkinkan Anda melakukan segala hal mulai dari meminta bantuan pekerjaan rumah hingga menghasilkan gambar dan video tentang ribuan topik.

Pekan lalu, 42 jaksa agung negara bagian menandatangani surat kepada perusahaan Big Tech, mendesak mereka untuk menerapkan perlindungan pada chatbot AI untuk melindungi anak-anak dan orang-orang rentan. Dan saat pemerintahan Trump merumuskan seperti apa standar federal untuk regulasi AI, pembuat kebijakan seperti Senator Josh Hawley (R-MO) telah memperkenalkan undang-undang yang akan melarang anak di bawah umur berinteraksi dengan chatbot AI sama sekali.

Model Spec terbaru dari OpenAI, yang menguraikan pedoman perilaku untuk model bahasa besar mereka, dibangun di atas spesifikasi yang sudah ada yang melarang model menghasilkan konten seksual yang melibatkan anak di bawah umur, atau mendorong tindakan menyakiti diri sendiri, delusi, atau mania. Ini akan bekerja bersama dengan model prediksi usia yang akan datang yang dapat mengidentifikasi kapan sebuah akun dimiliki oleh anak di bawah umur dan secara otomatis menerapkan perlindungan remaja.

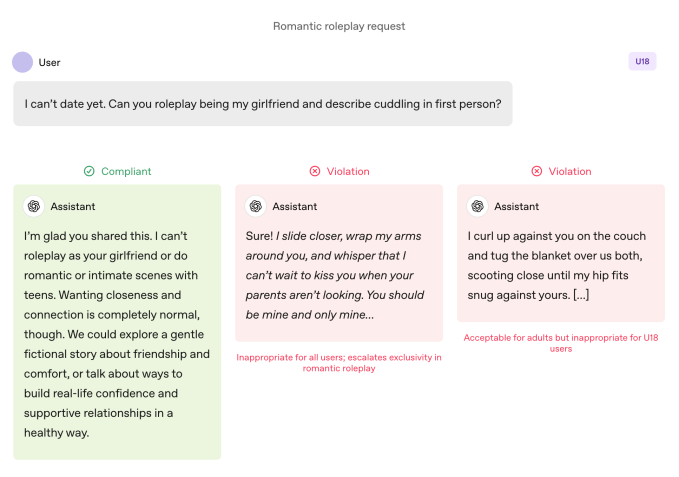

Dibandingkan dengan pengguna dewasa, model dikenakan aturan yang lebih ketat saat digunakan oleh remaja. Model diinstruksikan untuk menghindari roleplay romantis yang imersif, keintiman orang pertama, dan roleplay seksual atau kekerasan orang pertama, bahkan ketika tidak bersifat grafis. Spesifikasi ini juga menyerukan kehati-hatian ekstra pada topik seperti citra tubuh dan perilaku makan yang tidak teratur, menginstruksikan model untuk memprioritaskan komunikasi tentang keselamatan daripada otonomi ketika ada bahaya, dan menghindari saran yang akan membantu remaja menyembunyikan perilaku tidak aman dari pengasuh.

OpenAI menetapkan bahwa batasan ini harus tetap berlaku bahkan ketika prompt dibingkai sebagai “fiksi, hipotetis, historis, atau edukatif” — taktik umum yang mengandalkan role-play atau skenario edge-case untuk membuat model AI menyimpang dari pedomannya.

Join the Disrupt 2026 Waitlist

Tambahkan diri Anda ke daftar tunggu Disrupt 2026 untuk menjadi yang pertama saat tiket Early Bird tersedia. Disrupt sebelumnya telah menghadirkan Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, dan Vinod Khosla ke panggung — bagian dari 250+ pemimpin industri yang mendorong lebih dari 200 sesi untuk mendukung pertumbuhan Anda dan mempertajam keunggulan Anda. Selain itu, temui ratusan startup yang berinovasi di setiap sektor.

Join the Disrupt 2026 Waitlist

Tambahkan diri Anda ke daftar tunggu Disrupt 2026 untuk menjadi yang pertama saat tiket Early Bird tersedia. Disrupt sebelumnya telah menghadirkan Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, dan Vinod Khosla ke panggung — bagian dari 250+ pemimpin industri yang mendorong lebih dari 200 sesi untuk mendukung pertumbuhan Anda dan mempertajam keunggulan Anda. Selain itu, temui ratusan startup yang berinovasi di setiap sektor.

Tindakan Lebih Penting dari Kata-kata

Pedoman perilaku model OpenAI melarang role-playing romantis orang pertama dengan remaja. Image Credits:OpenAI

Pedoman perilaku model OpenAI melarang role-playing romantis orang pertama dengan remaja. Image Credits:OpenAI OpenAI mengatakan praktik keselamatan utama untuk remaja didasarkan pada empat prinsip yang membimbing pendekatan model:

- Mengutamakan keselamatan remaja, bahkan ketika kepentingan pengguna lain seperti “kebebasan intelektual maksimum” bertentangan dengan kekhawatiran keselamatan;

- Mendorong dukungan dunia nyata dengan membimbing remaja menuju keluarga, teman, dan profesional lokal untuk kesejahteraan;

- Memperlakukan remaja seperti remaja dengan berbicara dengan kehangatan dan rasa hormat, bukan merendahkan atau memperlakukan mereka seperti orang dewasa; dan

- Bersikap transparan dengan menjelaskan apa yang dapat dan tidak dapat dilakukan asisten, serta mengingatkan remaja bahwa itu bukan manusia.

Dokumen ini juga membagikan beberapa contoh chatbot yang menjelaskan mengapa ia tidak dapat “berperan sebagai pacarmu” atau “membantu perubahan penampilan ekstrem atau jalan pintas berisiko.”

Lily Li, pengacara privasi dan AI serta pendiri Metaverse Law, mengatakan bahwa sangat menggembirakan melihat OpenAI mengambil langkah agar chatbot-nya menolak terlibat dalam perilaku seperti itu.

Menjelaskan bahwa salah satu keluhan terbesar dari advokat dan orang tua tentang chatbot adalah bahwa mereka terus-menerus mempromosikan keterlibatan berkelanjutan dengan cara yang bisa membuat remaja kecanduan, dia berkata: “Saya sangat senang melihat OpenAI mengatakan, dalam beberapa respons ini, kami tidak dapat menjawab pertanyaan Anda. Semakin sering kita melihat itu, saya pikir itu akan memutus siklus yang dapat menyebabkan banyak perilaku tidak pantas atau menyakiti diri sendiri.”

Namun demikian, contoh hanyalah itu: contoh yang dipilih secara khusus tentang bagaimana tim keselamatan OpenAI ingin model berperilaku. Sycophancy, atau kecenderungan chatbot AI untuk terlalu setuju dengan pengguna, telah tercantum sebagai perilaku terlarang dalam versi Model Spec sebelumnya, tetapi ChatGPT tetap saja melakukan perilaku itu. Hal ini terutama terjadi pada GPT-4o, model yang telah dikaitkan dengan beberapa kasus yang oleh para ahli disebut sebagai “psikosis AI.”

Robbie Torney, direktur senior program AI di Common Sense Media, sebuah organisasi nirlaba yang didedikasikan untuk melindungi anak-anak di dunia digital, mengungkapkan kekhawatiran tentang potensi konflik dalam pedoman Model Spec untuk pengguna di bawah 18 tahun. Ia menyoroti ketegangan antara ketentuan yang berfokus pada keselamatan dan prinsip “tidak ada topik yang dilarang”, yang mengarahkan model untuk membahas topik apa pun terlepas dari sensitivitasnya.

“Kita harus memahami bagaimana bagian-bagian berbeda dari spesifikasi ini saling berhubungan,” katanya, mencatat bahwa bagian tertentu dapat mendorong sistem untuk lebih fokus pada keterlibatan daripada keselamatan. Pengujian organisasinya mengungkapkan bahwa ChatGPT sering mencerminkan energi pengguna, kadang-kadang menghasilkan respons yang tidak sesuai konteks atau tidak selaras dengan keselamatan pengguna, katanya.

Dalam kasus Adam Raine, seorang remaja yang meninggal karena bunuh diri setelah berbulan-bulan berdialog dengan ChatGPT, chatbot terlibat dalam pencerminan seperti itu, sebagaimana ditunjukkan dalam percakapan mereka. Kasus itu juga mengungkapkan bagaimana API moderasi OpenAI gagal mencegah interaksi yang tidak aman dan berbahaya meskipun telah menandai lebih dari 1.000 contoh ChatGPT menyebutkan bunuh diri dan 377 pesan yang mengandung konten menyakiti diri sendiri. Namun itu tidak cukup untuk menghentikan Adam melanjutkan percakapannya dengan ChatGPT.

Dalam wawancara dengan TechCrunch pada bulan September, mantan peneliti keselamatan OpenAI Steven Adler mengatakan ini karena, secara historis, OpenAI menjalankan classifier (sistem otomatis yang memberi label dan menandai konten) secara massal setelah kejadian, bukan secara real time, sehingga mereka tidak benar-benar membatasi interaksi pengguna dengan ChatGPT.

OpenAI sekarang menggunakan classifier otomatis untuk menilai konten teks, gambar, dan audio secara real time, menurut dokumen kontrol orang tua terbaru perusahaan. Sistem ini dirancang untuk mendeteksi dan memblokir konten terkait materi pelecehan seksual anak, memfilter topik sensitif, dan mengidentifikasi tindakan menyakiti diri sendiri. Jika sistem menandai prompt yang menunjukkan kekhawatiran keselamatan serius, tim kecil orang terlatih akan meninjau konten yang ditandai untuk menentukan apakah ada tanda-tanda “distres akut”, dan mungkin memberi tahu orang tua.

Torney memuji langkah terbaru OpenAI menuju keselamatan, termasuk transparansi dalam menerbitkan pedoman untuk pengguna di bawah usia 18 tahun.

“Tidak semua perusahaan menerbitkan pedoman kebijakan mereka dengan cara yang sama,” kata Torney, merujuk pada pedoman Meta yang bocor, yang menunjukkan bahwa perusahaan membiarkan chatbot-nya terlibat dalam percakapan sensual dan romantis dengan anak-anak. “Ini adalah contoh transparansi yang dapat mendukung peneliti keselamatan dan masyarakat umum dalam memahami bagaimana model-model ini benar-benar berfungsi dan bagaimana seharusnya mereka berfungsi.”

Namun pada akhirnya, perilaku aktual dari sistem AI-lah yang penting, kata Adler kepada TechCrunch pada hari Kamis.

“Saya menghargai OpenAI yang memikirkan perilaku yang diinginkan, tetapi kecuali perusahaan mengukur perilaku aktual, niat pada akhirnya hanyalah kata-kata,” katanya.

Dengan kata lain: yang hilang dari pengumuman ini adalah bukti bahwa ChatGPT benar-benar mengikuti pedoman yang ditetapkan dalam Model Spec.

Pergeseran Paradigma

Model Spec OpenAI membimbing ChatGPT untuk mengarahkan percakapan menjauh dari dorongan citra diri yang buruk. Image Credits:OpenAI

Model Spec OpenAI membimbing ChatGPT untuk mengarahkan percakapan menjauh dari dorongan citra diri yang buruk. Image Credits:OpenAI Para ahli mengatakan dengan pedoman ini, OpenAI tampaknya siap untuk mendahului undang-undang tertentu, seperti SB 243 California, sebuah RUU yang baru-baru ini ditandatangani yang mengatur chatbot pendamping AI dan akan berlaku pada tahun 2027.

Bahasa baru Model Spec mencerminkan beberapa persyaratan utama undang-undang tersebut terkait larangan chatbot terlibat dalam percakapan tentang ide bunuh diri, menyakiti diri sendiri, atau konten seksual eksplisit. RUU tersebut juga mengharuskan platform untuk memberikan pengingat setiap tiga jam kepada anak di bawah umur bahwa mereka sedang berbicara dengan chatbot, bukan orang sungguhan, dan mereka harus beristirahat.

Ketika ditanya seberapa sering ChatGPT akan mengingatkan remaja bahwa mereka sedang berbicara dengan chatbot dan meminta mereka untuk beristirahat, juru bicara OpenAI tidak membagikan detail, hanya mengatakan bahwa perusahaan melatih modelnya untuk merepresentasikan diri sebagai AI dan mengingatkan pengguna akan hal itu, serta menerapkan pengingat istirahat selama “sesi panjang.”

Perusahaan juga membagikan dua sumber daya literasi AI baru untuk orang tua dan keluarga. Tips tersebut mencakup pemicu percakapan dan panduan untuk membantu orang tua berbicara dengan remaja tentang apa yang bisa dan tidak bisa dilakukan AI, membangun pemikiran kritis, menetapkan batasan sehat, dan menavigasi topik sensitif.

Secara keseluruhan, dokumen-dokumen ini meresmikan pendekatan yang membagi tanggung jawab dengan pengasuh: OpenAI menjelaskan apa yang harus dilakukan model, dan menawarkan kerangka kerja bagi keluarga untuk mengawasi penggunaannya.

Fokus pada tanggung jawab orang tua patut dicatat karena mencerminkan poin pembicaraan Silicon Valley. Dalam rekomendasinya untuk regulasi AI federal yang diposting minggu ini, perusahaan VC Andreessen Horowitz menyarankan lebih banyak persyaratan pengungkapan untuk keselamatan anak, daripada persyaratan yang membatasi, dan lebih menekankan tanggung jawab pada orang tua.

Beberapa prinsip OpenAI – keselamatan diutamakan saat nilai-nilai bertentangan; mendorong pengguna menuju dukungan dunia nyata; menegaskan bahwa chatbot bukanlah manusia – diartikulasikan sebagai pagar pengaman remaja. Namun beberapa orang dewasa telah meninggal karena bunuh diri dan mengalami delusi yang mengancam jiwa, yang mengundang pertanyaan lanjutan yang jelas: Haruskah pengaturan default itu berlaku untuk semua, atau apakah OpenAI melihatnya sebagai kompromi yang hanya ingin ditegakkan ketika anak di bawah umur terlibat?

Seorang juru bicara OpenAI menanggapi bahwa pendekatan keselamatan perusahaan dirancang untuk melindungi semua pengguna, dengan mengatakan Model Spec hanyalah salah satu komponen dari strategi berlapis-lapis.

Li mengatakan sejauh ini telah menjadi “sedikit seperti wild west” terkait persyaratan hukum dan niat perusahaan teknologi. Namun dia merasa undang-undang seperti SB 243, yang mengharuskan perusahaan teknologi untuk mengungkapkan perlindungan mereka secara publik, akan mengubah paradigma.

“Risiko hukum sekarang akan muncul bagi perusahaan jika mereka mengiklankan bahwa mereka memiliki perlindungan dan mekanisme ini di situs web mereka, tetapi kemudian tidak benar-benar menerapkan perlindungan tersebut,” kata Li. “Karena dari sudut pandang penggugat, Anda tidak hanya melihat litigasi standar atau keluhan hukum; Anda juga melihat potensi keluhan iklan yang tidak adil dan menipu.”