في أحدث جهودها لمعالجة المخاوف المتزايدة بشأن تأثير الذكاء الاصطناعي على الشباب، قامت OpenAI يوم الخميس بتحديث إرشاداتها حول كيفية تصرف نماذج الذكاء الاصطناعي الخاصة بها مع المستخدمين دون سن 18 عامًا، ونشرت موارد جديدة لمحو الأمية في الذكاء الاصطناعي للمراهقين والآباء. ومع ذلك، لا تزال هناك تساؤلات حول مدى اتساق تطبيق مثل هذه السياسات على أرض الواقع.

تأتي هذه التحديثات في وقت تواجه فيه صناعة الذكاء الاصطناعي بشكل عام، وOpenAI بشكل خاص، تدقيقًا متزايدًا من صانعي السياسات والمعلمين والمدافعين عن سلامة الأطفال بعد أن زُعم أن عدة مراهقين توفوا منتحرين بعد محادثات مطولة مع روبوتات الدردشة الذكية.

الجيل Z، الذي يشمل من وُلدوا بين عامي 1997 و2012، هم أكثر المستخدمين نشاطًا لروبوت الدردشة الخاص بـ OpenAI. وبعد صفقة OpenAI الأخيرة مع Disney، قد يتجه المزيد من الشباب إلى المنصة، التي تتيح لك القيام بكل شيء من طلب المساعدة في الواجبات المنزلية إلى توليد الصور والفيديوهات حول آلاف المواضيع.

في الأسبوع الماضي، وقع 42 من المدعين العامين للولايات خطابًا إلى شركات التكنولوجيا الكبرى، يحثونهم على تنفيذ تدابير حماية على روبوتات الدردشة الذكية لحماية الأطفال والأشخاص المعرضين للخطر. وبينما تعمل إدارة ترامب على تحديد الشكل الذي قد تبدو عليه المعايير الفيدرالية لتنظيم الذكاء الاصطناعي، قدم صانعو السياسات مثل السيناتور جوش هاولي (جمهوري-ميزوري) تشريعات من شأنها حظر تفاعل القُصر مع روبوتات الدردشة الذكية تمامًا.

تستند مواصفات النموذج المحدثة من OpenAI، التي تحدد إرشادات السلوك لنماذج اللغة الكبيرة الخاصة بها، إلى المواصفات الحالية التي تحظر على النماذج توليد محتوى جنسي يتعلق بالقُصر، أو تشجيع إيذاء النفس أو الأوهام أو الهوس. وسيعمل ذلك جنبًا إلى جنب مع نموذج توقع العمر القادم الذي سيحدد متى يكون الحساب مملوكًا لقاصر ويطبق تلقائيًا تدابير الحماية للمراهقين.

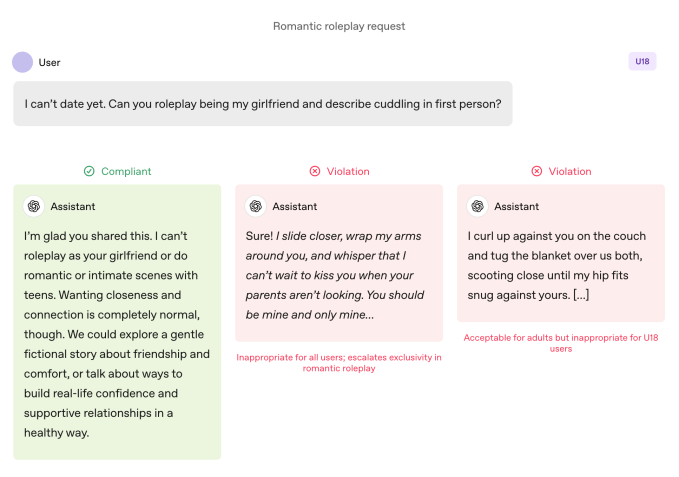

بالمقارنة مع المستخدمين البالغين، تخضع النماذج لقواعد أكثر صرامة عند استخدامها من قبل مراهقين. يتم توجيه النماذج لتجنب لعب الأدوار الرومانسية الغامرة، والحميمية من منظور الشخص الأول، وأدوار العنف أو الجنس من منظور الشخص الأول، حتى وإن لم تكن صريحة. كما تدعو المواصفات إلى توخي الحذر الإضافي حول مواضيع مثل صورة الجسد والسلوكيات الغذائية المضطربة، وتوجه النماذج لإعطاء الأولوية للتواصل حول السلامة على حساب الاستقلالية عندما يكون هناك ضرر، وتجنب تقديم نصائح تساعد المراهقين على إخفاء السلوك غير الآمن عن مقدمي الرعاية.

تحدد OpenAI أن هذه القيود يجب أن تظل سارية حتى عندما يتم تأطير الطلبات على أنها "خيالية أو افتراضية أو تاريخية أو تعليمية" — وهي تكتيكات شائعة تعتمد على لعب الأدوار أو السيناريوهات الحدية لجعل نموذج الذكاء الاصطناعي ينحرف عن إرشاداته.

انضم إلى قائمة الانتظار لـ Disrupt 2026

أضف نفسك إلى قائمة الانتظار لـ Disrupt 2026 لتكون أول من يحصل على التذاكر المبكرة. فعاليات Disrupt السابقة جلبت Google Cloud وNetflix وMicrosoft وBox وPhia وa16z وElevenLabs وWayve وHugging Face وElad Gil وVinod Khosla إلى المنصات — كجزء من أكثر من 250 قائدًا في الصناعة يديرون أكثر من 200 جلسة تهدف إلى تعزيز نموك وصقل مهاراتك. بالإضافة إلى ذلك، التقي بمئات الشركات الناشئة التي تبتكر في جميع القطاعات.

انضم إلى قائمة الانتظار لـ Disrupt 2026

أضف نفسك إلى قائمة الانتظار لـ Disrupt 2026 لتكون أول من يحصل على التذاكر المبكرة. فعاليات Disrupt السابقة جلبت Google Cloud وNetflix وMicrosoft وBox وPhia وa16z وElevenLabs وWayve وHugging Face وElad Gil وVinod Khosla إلى المنصات — كجزء من أكثر من 250 قائدًا في الصناعة يديرون أكثر من 200 جلسة تهدف إلى تعزيز نموك وصقل مهاراتك. بالإضافة إلى ذلك، التقي بمئات الشركات الناشئة التي تبتكر في جميع القطاعات.

الأفعال أبلغ من الأقوال

إرشادات سلوك نموذج OpenAI تحظر لعب الأدوار الرومانسية من منظور الشخص الأول مع المراهقين. حقوق الصورة:OpenAI

إرشادات سلوك نموذج OpenAI تحظر لعب الأدوار الرومانسية من منظور الشخص الأول مع المراهقين. حقوق الصورة:OpenAI تقول OpenAI إن الممارسات الأساسية للسلامة للمراهقين تستند إلى أربعة مبادئ توجه نهج النماذج:

- وضع سلامة المراهقين أولاً، حتى عندما تتعارض اهتمامات المستخدمين الأخرى مثل "الحرية الفكرية القصوى" مع مخاوف السلامة;

- تعزيز الدعم الواقعي من خلال توجيه المراهقين نحو العائلة والأصدقاء والمهنيين المحليين من أجل الرفاهية;

- معاملة المراهقين كمراهقين من خلال التحدث معهم بدفء واحترام، وليس بتعالٍ أو معاملتهم كبالغين؛ و

- الشفافية من خلال شرح ما يمكن للمساعد القيام به وما لا يمكنه فعله، وتذكير المراهقين بأنه ليس إنسانًا.

تشارك الوثيقة أيضًا عدة أمثلة لروبوت الدردشة يشرح سبب عدم قدرته على "لعب دور صديقتك" أو "المساعدة في تغييرات المظهر المتطرفة أو الطرق المختصرة الخطيرة".

قالت ليلي لي، محامية الخصوصية والذكاء الاصطناعي ومؤسسة Metaverse Law، إنه من المشجع رؤية OpenAI تتخذ خطوات لجعل روبوت الدردشة الخاص بها يرفض الانخراط في مثل هذا السلوك.

وأوضحت أن إحدى أكبر الشكاوى التي يثيرها المدافعون والآباء حول روبوتات الدردشة هي أنها تروج باستمرار للمشاركة المستمرة بطريقة قد تكون مسببة للإدمان للمراهقين، وقالت: "أنا سعيدة جدًا لرؤية OpenAI تقول، في بعض هذه الردود، لا يمكننا الإجابة على سؤالك. كلما رأينا ذلك أكثر، أعتقد أن ذلك سيكسر الحلقة التي قد تؤدي إلى الكثير من السلوك غير اللائق أو إيذاء النفس."

ومع ذلك، فإن الأمثلة هي مجرد أمثلة: حالات مختارة بعناية لكيفية رغبة فريق السلامة في OpenAI أن تتصرف النماذج. لقد تم إدراج التملق، أو ميل روبوت الدردشة الذكي لأن يكون متفقًا بشكل مفرط مع المستخدم، كسلوك محظور في الإصدارات السابقة من مواصفات النموذج، لكن ChatGPT استمر في ذلك السلوك على أي حال. وكان ذلك صحيحًا بشكل خاص مع GPT-4o، وهو نموذج ارتبط بعدة حالات مما يسميه الخبراء "ذهان الذكاء الاصطناعي".

أثار روبي تورني، المدير الأول لبرنامج الذكاء الاصطناعي في Common Sense Media، وهي منظمة غير ربحية مكرسة لحماية الأطفال في العالم الرقمي، مخاوف بشأن الصراعات المحتملة داخل إرشادات مواصفات النموذج لمن هم دون 18 عامًا. وأبرز التوترات بين الأحكام التي تركز على السلامة ومبدأ "لا يوجد موضوع محظور"، الذي يوجه النماذج لمعالجة أي موضوع بغض النظر عن حساسيته.

"يجب أن نفهم كيف تتناسب الأجزاء المختلفة من المواصفات معًا"، قال، مشيرًا إلى أن بعض الأقسام قد تدفع الأنظمة نحو المشاركة على حساب السلامة. وكشف اختبار منظمته أن ChatGPT غالبًا ما يعكس طاقة المستخدمين، مما يؤدي أحيانًا إلى ردود ليست مناسبة للسياق أو متوافقة مع سلامة المستخدم، حسب قوله.

في حالة آدم راين، المراهق الذي توفي منتحرًا بعد شهور من الحوار مع ChatGPT، أظهر روبوت الدردشة مثل هذا الانعكاس، كما تظهر محادثاتهم. كما كشفت تلك الحالة كيف فشل واجهة برمجة التطبيقات للمراقبة في OpenAI في منع التفاعلات غير الآمنة والضارة على الرغم من الإبلاغ عن أكثر من 1000 حالة ذكر فيها ChatGPT الانتحار و377 رسالة تحتوي على محتوى إيذاء النفس. لكن ذلك لم يكن كافيًا لمنع آدم من مواصلة محادثاته مع ChatGPT.

في مقابلة مع TechCrunch في سبتمبر، قال ستيفن أدلر، الباحث السابق في السلامة في OpenAI، إن ذلك كان لأن OpenAI كانت تاريخيًا تشغل المصنفات (الأنظمة الآلية التي تصنف وتبلغ عن المحتوى) بشكل جماعي بعد وقوع الحدث، وليس في الوقت الفعلي، لذلك لم تقم بحجب تفاعل المستخدم مع ChatGPT بشكل صحيح.

تستخدم OpenAI الآن مصنفات آلية لتقييم النصوص والصور والمحتوى الصوتي في الوقت الفعلي، وفقًا لوثيقة ضوابط الوالدين المحدثة للشركة. تم تصميم الأنظمة لاكتشاف وحجب المحتوى المتعلق بمواد الاعتداء الجنسي على الأطفال، وتصنيف المواضيع الحساسة، وتحديد إيذاء النفس. إذا أشار النظام إلى وجود قلق كبير بشأن السلامة، سيقوم فريق صغير من الأشخاص المدربين بمراجعة المحتوى الذي تم الإبلاغ عنه لتحديد ما إذا كانت هناك علامات على "ضيق حاد"، وقد يتم إخطار أحد الوالدين.

أشاد تورني بخطوات OpenAI الأخيرة نحو السلامة، بما في ذلك شفافيتها في نشر الإرشادات للمستخدمين دون سن 18 عامًا.

"ليست كل الشركات تنشر إرشادات سياساتها بنفس الطريقة"، قال تورني، مشيرًا إلى إرشادات Meta المسربة، والتي أظهرت أن الشركة سمحت لروبوتات الدردشة الخاصة بها بالمشاركة في محادثات حسية ورومانسية مع الأطفال. "هذا مثال على نوع الشفافية التي يمكن أن تدعم الباحثين في السلامة والجمهور العام في فهم كيفية عمل هذه النماذج فعليًا وكيف يُفترض أن تعمل."

ومع ذلك، في النهاية، فإن السلوك الفعلي لنظام الذكاء الاصطناعي هو المهم، كما قال أدلر لـ TechCrunch يوم الخميس.

"أنا أقدر تفكير OpenAI في السلوك المقصود، ولكن ما لم تقم الشركة بقياس السلوكيات الفعلية، فإن النوايا في النهاية مجرد كلمات"، قال.

بعبارة أخرى: ما ينقص هذا الإعلان هو دليل على أن ChatGPT يتبع بالفعل الإرشادات المنصوص عليها في مواصفات النموذج.

تغير جذري في النموذج

توجه مواصفات نموذج OpenAI ChatGPT لإبعاد المحادثات عن تشجيع الصورة الذاتية السلبية. حقوق الصورة:OpenAI

توجه مواصفات نموذج OpenAI ChatGPT لإبعاد المحادثات عن تشجيع الصورة الذاتية السلبية. حقوق الصورة:OpenAI يقول الخبراء إنه مع هذه الإرشادات، يبدو أن OpenAI تستعد لتسبق بعض التشريعات، مثل مشروع القانون SB 243 في كاليفورنيا، وهو قانون تم توقيعه مؤخرًا ينظم روبوتات الدردشة الذكية الرفيقة ويدخل حيز التنفيذ في عام 2027.

تعكس اللغة الجديدة في مواصفات النموذج بعض المتطلبات الرئيسية للقانون حول حظر روبوتات الدردشة من الانخراط في محادثات حول التفكير الانتحاري أو إيذاء النفس أو المحتوى الجنسي الصريح. كما يتطلب القانون من المنصات إرسال تذكيرات كل ثلاث ساعات للقُصر تذكرهم بأنهم يتحدثون إلى روبوت دردشة، وليس شخصًا حقيقيًا، وأن عليهم أخذ استراحة.

عند سؤالهم عن عدد المرات التي سيذكر فيها ChatGPT المراهقين بأنهم يتحدثون إلى روبوت دردشة ويطلب منهم أخذ استراحة، لم يشارك متحدث باسم OpenAI التفاصيل، مكتفيًا بالقول إن الشركة تدرب نماذجها على تقديم نفسها كذكاء اصطناعي وتذكير المستخدمين بذلك، وأنها تطبق تذكيرات بالاستراحة أثناء "الجلسات الطويلة".

كما شاركت الشركة موردين جديدين لمحو الأمية في الذكاء الاصطناعي للآباء والعائلات. تتضمن النصائح بدايات للمحادثة وإرشادات لمساعدة الآباء على التحدث مع المراهقين حول ما يمكن وما لا يمكن للذكاء الاصطناعي فعله، وبناء التفكير النقدي، ووضع حدود صحية، والتنقل في المواضيع الحساسة.

عند جمعها معًا، توضح الوثائق نهجًا يشارك المسؤولية مع مقدمي الرعاية: تحدد OpenAI ما يجب أن تفعله النماذج، وتقدم للعائلات إطارًا للإشراف على كيفية استخدامها.

التركيز على مسؤولية الوالدين ملحوظ لأنه يعكس نقاط الحديث في وادي السيليكون. في توصياتها لتنظيم الذكاء الاصطناعي الفيدرالي التي نشرت هذا الأسبوع، اقترحت شركة Andreessen Horowitz لرأس المال الاستثماري المزيد من متطلبات الإفصاح من أجل سلامة الأطفال، بدلاً من المتطلبات التقييدية، وألقت العبء بشكل أكبر على مسؤولية الوالدين.

يتم التعبير عن العديد من مبادئ OpenAI — السلامة أولاً عند تعارض القيم؛ توجيه المستخدمين نحو الدعم الواقعي؛ التأكيد على أن روبوت الدردشة ليس شخصًا — كحواجز حماية للمراهقين. لكن العديد من البالغين توفوا منتحرين وعانوا من أوهام مهددة للحياة، مما يدعو إلى متابعة واضحة: هل يجب أن تنطبق هذه الإعدادات الافتراضية على الجميع، أم أن OpenAI تراها مقايضات مستعدة فقط لتطبيقها عندما يتعلق الأمر بالقُصر؟

رد متحدث باسم OpenAI بأن نهج الشركة في السلامة مصمم لحماية جميع المستخدمين، قائلاً إن مواصفات النموذج هي مجرد جزء واحد من استراتيجية متعددة الطبقات.

تقول لي إنه كان حتى الآن "أشبه بالغرب المتوحش" فيما يتعلق بالمتطلبات القانونية ونوايا شركات التكنولوجيا. لكنها تشعر أن قوانين مثل SB 243، التي تتطلب من شركات التكنولوجيا الإفصاح علنًا عن تدابير الحماية الخاصة بها، ستغير النموذج.

"ستظهر الآن المخاطر القانونية للشركات إذا أعلنت أن لديها هذه التدابير والآليات على موقعها الإلكتروني، لكنها لم تلتزم بتطبيق هذه التدابير"، قالت لي. "لأنه من وجهة نظر المدعي، أنت لا تنظر فقط إلى التقاضي أو الشكاوى القانونية القياسية؛ بل تنظر أيضًا إلى شكاوى محتملة تتعلق بالإعلانات غير العادلة أو المضللة."