حدود جديدة لأمان الذكاء الاصطناعي: اختبار مشترك بين المختبرات لتوحيد الصناعة

- دعا Ilya Sutskever من OpenAI إلى إجراء اختبارات مشتركة بين المختبرات لتعزيز أمان الذكاء الاصطناعي في ظل التقدم التكنولوجي السريع والمخاطر الشاملة في القطاع. - تجربة Anthropic لنموذج Claude عبر المتصفح تسلط الضوء على تحديات الأمان مثل هجمات حقن المطالبات، مما يدفع لتبني استراتيجيات تخفيف محسنة. - كشفت دراسة عن التزام ضعيف بالمعايير الطوعية للسلامة من قبل شركات الذكاء الاصطناعي الكبرى، بما في ذلك Apple، مما يثير التساؤلات حول فعالية التنظيم الذاتي. - أطلقت Cloud Security Alliance مبادرة أمان الذكاء الاصطناعي التي تقدم أطر عمل وأداة RiskRub.

دعا المؤسس المشارك وعضو مجلس إدارة OpenAI، إيليا سوتسكيفر، إلى تنفيذ اختبارات مشتركة بين المختبرات كإجراء حاسم لضمان سلامة أنظمة الذكاء الاصطناعي. تأتي تصريحاته وسط تزايد المخاوف بشأن المخاطر المرتبطة بتطورات الذكاء الاصطناعي، حيث يؤكد قادة الصناعة على الحاجة إلى بروتوكولات أمان تعاونية وموحدة. تتماشى دعوة سوتسكيفر لاختبارات المختبرات المشتركة مع الجهود الأوسع لتعزيز سلامة الذكاء الاصطناعي والحد من الأضرار المحتملة مع استمرار تطور التكنولوجيا بسرعة [1].

تؤكد التطورات الأخيرة في نشر وتنظيم الذكاء الاصطناعي على الحاجة إلى مثل هذه الأساليب التعاونية. فعلى سبيل المثال، أطلقت Anthropic، وهي لاعب رئيسي في قطاع الذكاء الاصطناعي، برنامجًا تجريبيًا لمساعدها الذكي Claude، المصمم للعمل مباشرة في متصفحات المستخدمين. تهدف هذه المبادرة إلى تعزيز فائدة الذكاء الاصطناعي من خلال دمجه في سير العمل الرقمي الأساسي، كما سلطت الضوء أيضًا على التحديات الكبيرة المتعلقة بالأمان والسلامة المرتبطة بوكلاء الذكاء الاصطناعي المعتمدين على المتصفح. برزت هجمات حقن الأوامر الفورية—حيث يقوم جهات خبيثة بالتلاعب بسلوك الذكاء الاصطناعي عبر تضمين تعليمات مخفية—كخطر رئيسي، مما دفع Anthropic إلى تنفيذ استراتيجيات تخفيف قوية مثل أذونات على مستوى الموقع، وتأكيدات على الإجراءات، ومصنفات متقدمة لاكتشاف الأنماط المشبوهة [2].

هذه المخاطر ليست محصورة على الشركات الفردية فقط. فقد وجدت دراسة حديثة أجراها باحثون من Brown وHarvard وStanford أن العديد من شركات الذكاء الاصطناعي لم تلتزم بالكامل بتعهداتها الطوعية المتعلقة بالسلامة، خاصة بعد تعهدات إدارة بايدن في 2023 بشأن سلامة الذكاء الاصطناعي. على سبيل المثال، حصلت Apple على تقييم ضعيف، حيث وُجد دليل على الامتثال لواحد فقط من كل ثمانية التزامات. تسلط الدراسة الضوء على حدود التنظيم الذاتي في صناعة تتطور بسرعة، وتثير تساؤلات حول فعالية التدابير الطوعية في ضمان المساءلة والسلامة [5].

استجابة لهذه التحديات، أطلقت Cloud Security Alliance (CSA) مبادرة سلامة الذكاء الاصطناعي في أواخر 2023، وجمعت قادة الصناعة والوكالات الحكومية والمؤسسات الأكاديمية لتطوير أدوات وأطر عملية لإدارة مخاطر الذكاء الاصطناعي. توفر المبادرة قوائم تحقق لاستعداد الذكاء الاصطناعي، وأطر حوكمة، وإرشادات أمنية للمنظمات، بهدف مواءمة التقدم التكنولوجي مع التوقعات التنظيمية. ومن الجدير بالذكر أن CSA قدمت أيضًا RiskRubric.ai، وهو نظام تصنيف يقيم سلامة وشفافية وموثوقية نماذج اللغة الكبيرة (LLMs)، مما يوفر للمؤسسات نهجًا قائمًا على البيانات لاعتماد الذكاء الاصطناعي [4].

تدعم الجهود التعاونية لتعزيز سلامة الذكاء الاصطناعي أيضًا منظومة متنامية من الممولين وبرامج المنح. تقدم منظمات مثل Long-Term Future Fund وSurvival and Flourishing Fund وAI Safety Fund دعمًا ماليًا للباحثين ورواد الأعمال والمؤسسات التي تعمل على الحد من مخاطر الذكاء الاصطناعي. تهدف هذه المبادرات إلى معالجة المخاطر الوجودية طويلة الأمد مع تعزيز الابتكار المسؤول في الوقت ذاته. بالإضافة إلى ذلك، تستثمر شركات رأس المال الاستثماري مثل Juniper Ventures وMythos Ventures في الشركات الناشئة التي تطور أدوات لتحسين أمان الذكاء الاصطناعي والامتثال والحوكمة [6].

تمثل الدعوة إلى اختبارات مشتركة بين المختبرات، كما دعا إليها سوتسكيفر، خطوة محورية نحو معالجة هذه التحديات النظامية. من خلال تمكين المعايير المشتركة والتقييم الشفاف عبر مختبرات تطوير الذكاء الاصطناعي، يمكن للصناعة تعزيز الثقة والمساءلة بشكل أكبر. هذا النهج مهم بشكل خاص مع ازدياد تعقيد وقدرات أنظمة الذكاء الاصطناعي، مما يستلزم جبهة موحدة لتقييم المخاطر المحتملة قبل النشر. لدى OpenAI وAnthropic وغيرهم من أصحاب المصلحة الرئيسيين فرصة—ومسؤولية—لقيادة هذا التحول من خلال تبني بروتوكولات السلامة التعاونية ووضع سابقة للابتكار المسؤول في مجال الذكاء الاصطناعي [1].

إخلاء المسؤولية: يعكس محتوى هذه المقالة رأي المؤلف فقط ولا يمثل المنصة بأي صفة. لا يُقصد من هذه المقالة أن تكون بمثابة مرجع لاتخاذ قرارات الاستثمار.

You may also like

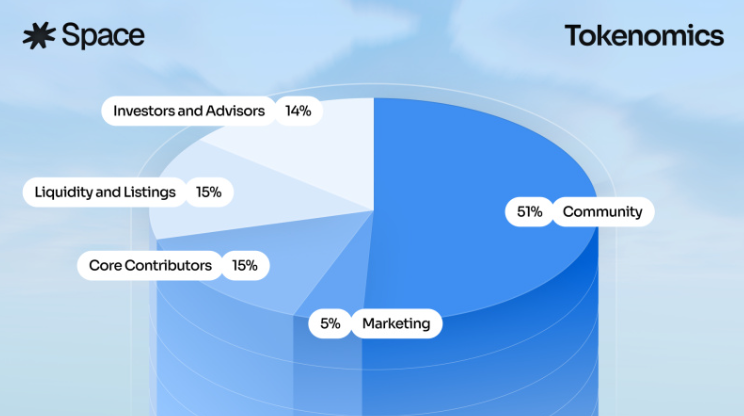

Space تطلق بيع عام لرمزها الأصلي SPACE

فتح باب الابتكار: الاحتياطي الفيدرالي الأمريكي يزيل العوائق أمام أعمال العملات الرقمية للبنوك

تحليل عميق وراء التقلبات الشديدة في سوق BTC