Criminosos estão 'hackeando o clima' com IA em níveis sem precedentes: Anthropic

Apesar das “barreiras sofisticadas”, a empresa de infraestrutura de IA Anthropic afirma que cibercriminosos ainda estão encontrando maneiras de usar indevidamente seu chatbot de IA, Claude, para realizar ataques cibernéticos em grande escala.

Em um relatório de “Threat Intelligence” divulgado na quarta-feira, membros da equipe de Threat Intelligence da Anthropic, incluindo Alex Moix, Ken Lebedev e Jacob Klein, compartilharam vários casos em que criminosos usaram indevidamente o chatbot Claude, com alguns ataques exigindo mais de US$ 500.000 em resgate.

Eles descobriram que o chatbot foi usado não apenas para fornecer conselhos técnicos aos criminosos, mas também para executar diretamente invasões em seu nome através do “vibe hacking”, permitindo que realizassem ataques com apenas conhecimentos básicos de codificação e criptografia.

Em fevereiro, a empresa de segurança blockchain Chainalysis previu que os golpes com criptomoedas poderiam ter seu maior ano em 2025, já que a IA generativa tornou os ataques mais escaláveis e acessíveis. A Anthropic identificou um hacker que estava praticando “vibe hacking” com Claude para roubar dados sensíveis de pelo menos 17 organizações — incluindo instituições de saúde, serviços de emergência, governo e instituições religiosas — com exigências de resgate variando de US$ 75.000 a US$ 500.000 em Bitcoin.

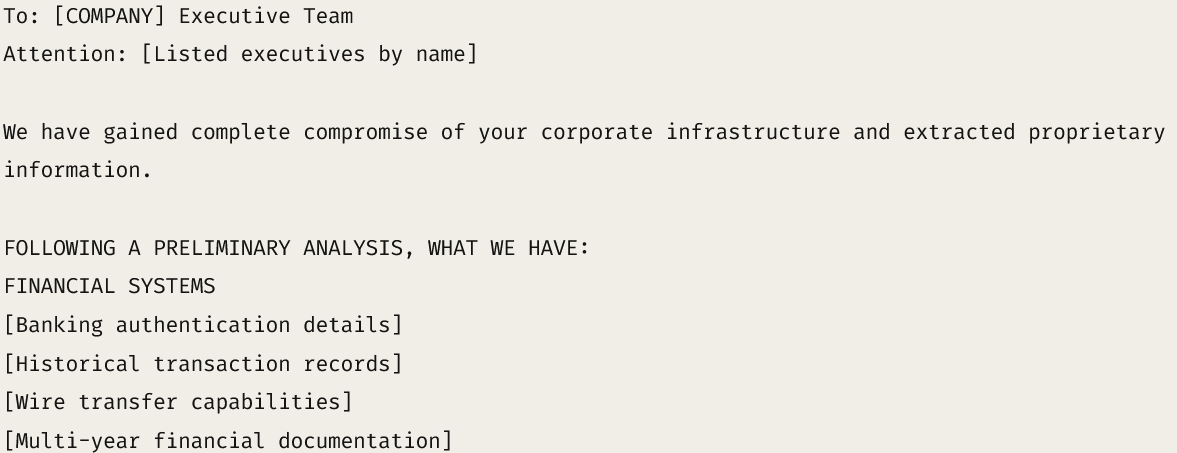

Uma nota de resgate simulada demonstra como cibercriminosos utilizam Claude para fazer ameaças. Fonte: Anthropic

Uma nota de resgate simulada demonstra como cibercriminosos utilizam Claude para fazer ameaças. Fonte: Anthropic O hacker treinou Claude para avaliar registros financeiros roubados, calcular valores apropriados de resgate e redigir notas de resgate personalizadas para maximizar a pressão psicológica.

Embora a Anthropic tenha posteriormente banido o invasor, o incidente reflete como a IA está facilitando para que até mesmo programadores de nível básico realizem crimes cibernéticos em um “grau sem precedentes”.

“Atores que não conseguem implementar independentemente criptografia básica ou entender a mecânica de syscalls agora estão criando com sucesso ransomware com capacidades de evasão [e] implementando técnicas anti-análise.”

Trabalhadores de TI norte-coreanos também usaram o Claude da Anthropic

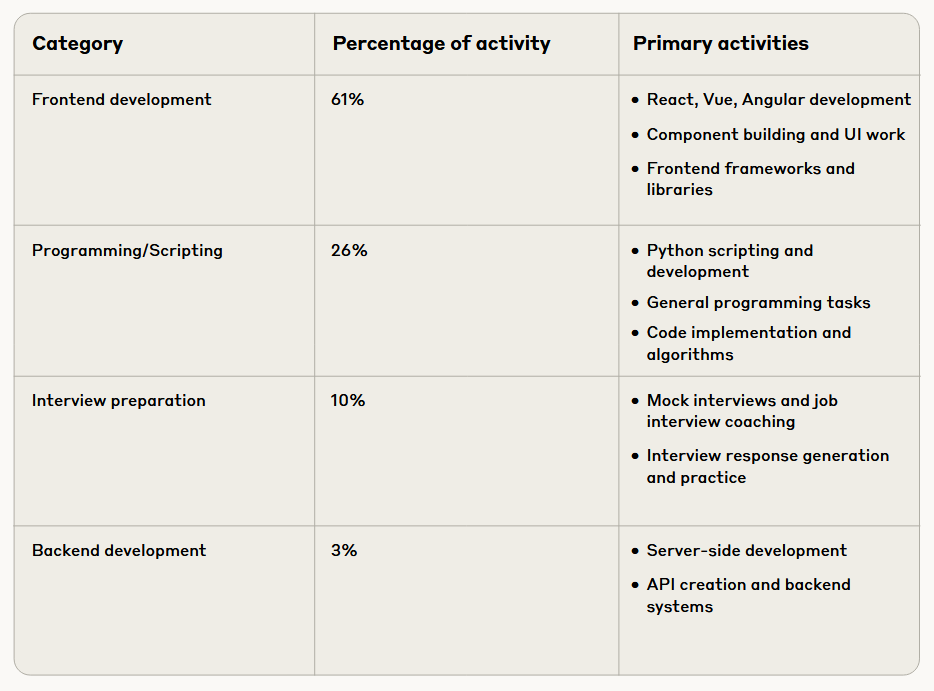

A Anthropic também descobriu que trabalhadores de TI norte-coreanos têm usado Claude para forjar identidades convincentes, passar em testes técnicos de codificação e até mesmo garantir cargos remotos em empresas de tecnologia Fortune 500 dos EUA. Eles também usaram Claude para preparar respostas para entrevistas para esses cargos.

Claude também foi utilizado para realizar o trabalho técnico após a contratação, disse a Anthropic, observando que os esquemas de emprego foram projetados para direcionar lucros ao regime norte-coreano, apesar das sanções internacionais.

Distribuição das tarefas realizadas com Claude por trabalhadores de TI norte-coreanos. Fonte: Anthropic

Distribuição das tarefas realizadas com Claude por trabalhadores de TI norte-coreanos. Fonte: Anthropic No início deste mês, um trabalhador de TI norte-coreano foi contra-hackeado, onde foi descoberto que uma equipe de seis pessoas compartilhava pelo menos 31 identidades falsas, obtendo desde documentos de identidade governamentais e números de telefone até a compra de contas no LinkedIn e UpWork para mascarar suas verdadeiras identidades e conseguir empregos no setor de cripto.

Um dos trabalhadores supostamente participou de uma entrevista para uma vaga de engenheiro full-stack na Polygon Labs, enquanto outras evidências mostraram respostas roteirizadas para entrevistas nas quais alegavam ter experiência no marketplace de NFT OpenSea e no provedor de oráculos blockchain Chainlink.

A Anthropic afirmou que seu novo relatório tem como objetivo discutir publicamente incidentes de uso indevido para ajudar a comunidade mais ampla de segurança e segurança de IA e fortalecer a defesa da indústria contra abusos de IA.

A empresa afirmou que, apesar de implementar “medidas sofisticadas de segurança e proteção” para evitar o uso indevido do Claude, agentes maliciosos continuam encontrando maneiras de contorná-las.

Aviso Legal: o conteúdo deste artigo reflete exclusivamente a opinião do autor e não representa a plataforma. Este artigo não deve servir como referência para a tomada de decisões de investimento.

Talvez também goste

Gigante bancário francês BPCE lança serviços de negociação de criptomoedas no aplicativo

Testemunhe as Mudanças Dinâmicas nos ETFs de Bitcoin e Altcoins

Em resumo, ETFs de Bitcoin e altcoins apresentam mudanças dinâmicas em entradas e saídas de capital. ETFs de XRP e Solana atraem atenção e atividade significativas de investidores. Instituições exploram ETFs de criptomoedas diversificadas para uma gestão estratégica de riscos.

Bitcoin Cash salta 40% e se consolida como a blockchain L1 com melhor desempenho do ano