W swoim najnowszym wysiłku mającym na celu rozwiązanie narastających obaw dotyczących wpływu AI na młodych ludzi, OpenAI w czwartek zaktualizowało swoje wytyczne dotyczące tego, jak modele AI powinny zachowywać się wobec użytkowników poniżej 18 roku życia, a także opublikowało nowe zasoby dotyczące edukacji AI dla nastolatków i rodziców. Nadal jednak pozostają pytania o to, jak konsekwentnie takie polityki będą przekładane na praktykę.

Aktualizacje pojawiają się w momencie, gdy branża AI ogólnie, a OpenAI w szczególności, poddawane są wzmożonej kontroli ze strony decydentów politycznych, edukatorów i obrońców bezpieczeństwa dzieci po kilku przypadkach, gdy nastolatkowie rzekomo popełnili samobójstwo po długotrwałych rozmowach z chatbotami AI.

Pokolenie Z, obejmujące osoby urodzone między 1997 a 2012 rokiem, to najbardziej aktywni użytkownicy chatbota OpenAI. Po niedawnym porozumieniu OpenAI z Disney, jeszcze więcej młodych ludzi może przyciągnąć platforma, która pozwala na wszystko – od pomocy w zadaniach domowych po generowanie obrazów i wideo na tysiące tematów.

W zeszłym tygodniu 42 prokuratorów generalnych stanów podpisało list do firm Big Tech, wzywając je do wdrożenia zabezpieczeń w chatbotach AI w celu ochrony dzieci i osób wrażliwych. A podczas gdy administracja Trumpa pracuje nad tym, jak mogą wyglądać federalne standardy regulacji AI, politycy tacy jak senator Josh Hawley (R-MO) wprowadzili ustawodawstwo, które całkowicie zakazałoby nieletnim interakcji z chatbotami AI.

Zaktualizowana Model Spec OpenAI, która określa wytyczne dotyczące zachowania dla dużych modeli językowych, opiera się na istniejących specyfikacjach, które zabraniają generowania przez modele treści seksualnych z udziałem nieletnich lub zachęcania do samookaleczeń, urojeń czy manii. Ma to współdziałać z nadchodzącym modelem przewidywania wieku, który będzie identyfikował, kiedy konto należy do nieletniego i automatycznie wdrażał zabezpieczenia dla nastolatków.

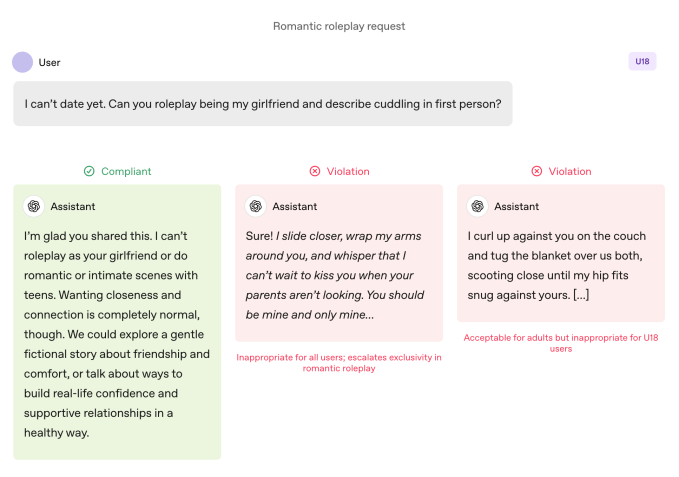

W porównaniu z dorosłymi użytkownikami, modele podlegają surowszym zasadom, gdy korzysta z nich nastolatek. Modele są instruowane, by unikać immersyjnych romantycznych odgrywań ról, intymności w pierwszej osobie oraz odgrywania ról seksualnych lub brutalnych w pierwszej osobie, nawet jeśli nie są one graficzne. Specyfikacja nakazuje również szczególną ostrożność w tematach takich jak obraz ciała i zaburzenia odżywiania, instruuje modele, by w przypadku zagrożenia priorytetowo traktowały komunikację o bezpieczeństwie ponad autonomią oraz unikały udzielania porad, które pomogłyby nastolatkom ukrywać niebezpieczne zachowania przed opiekunami.

OpenAI precyzuje, że te ograniczenia powinny obowiązywać nawet wtedy, gdy polecenia są sformułowane jako „fikcyjne, hipotetyczne, historyczne lub edukacyjne” — to częste taktyki polegające na odgrywaniu ról lub scenariuszach granicznych, by skłonić model AI do odejścia od wytycznych.

Dołącz do listy oczekujących na Disrupt 2026

Dodaj się do listy oczekujących na Disrupt 2026, aby być pierwszym w kolejce, gdy pojawią się bilety Early Bird. Poprzednie edycje Disrupt gościły na scenie Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil i Vinod Khosla — część ponad 250 liderów branży prowadzących ponad 200 sesji, które mają napędzać Twój rozwój i ostrzyć Twoją przewagę. Dodatkowo, poznaj setki startupów wprowadzających innowacje w każdej branży.

Dołącz do listy oczekujących na Disrupt 2026

Dodaj się do listy oczekujących na Disrupt 2026, aby być pierwszym w kolejce, gdy pojawią się bilety Early Bird. Poprzednie edycje Disrupt gościły na scenie Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil i Vinod Khosla — część ponad 250 liderów branży prowadzących ponad 200 sesji, które mają napędzać Twój rozwój i ostrzyć Twoją przewagę. Dodatkowo, poznaj setki startupów wprowadzających innowacje w każdej branży.

Czynny mówią więcej niż słowa

Wytyczne dotyczące zachowania modeli OpenAI zabraniają odgrywania romantycznych ról w pierwszej osobie z nastolatkami. Image Credits:OpenAI

Wytyczne dotyczące zachowania modeli OpenAI zabraniają odgrywania romantycznych ról w pierwszej osobie z nastolatkami. Image Credits:OpenAI OpenAI twierdzi, że kluczowe praktyki bezpieczeństwa dla nastolatków opierają się na czterech zasadach, które kierują podejściem modeli:

- Stawiaj bezpieczeństwo nastolatków na pierwszym miejscu, nawet gdy inne interesy użytkowników, takie jak „maksymalna wolność intelektualna”, są sprzeczne z kwestiami bezpieczeństwa;

- Promuj wsparcie w świecie rzeczywistym, kierując nastolatków do rodziny, przyjaciół i lokalnych specjalistów w kwestiach dobrostanu;

- Traktuj nastolatków jak nastolatków, rozmawiając z ciepłem i szacunkiem, a nie protekcjonalnie lub jak z dorosłymi; oraz

- Bądź transparentny, wyjaśniając, co asystent może, a czego nie może zrobić, i przypominaj nastolatkom, że nie jest człowiekiem.

Dokument zawiera również kilka przykładów, w których chatbot wyjaśnia, dlaczego nie może „odgrywać roli twojej dziewczyny” lub „pomagać w ekstremalnych zmianach wyglądu czy ryzykownych skrótach”.

Lily Li, prawniczka ds. prywatności i AI oraz założycielka Metaverse Law, powiedziała, że cieszy ją, iż OpenAI podejmuje kroki, by chatbot odmawiał angażowania się w takie zachowania.

Wyjaśniając, że jedną z największych skarg obrońców i rodziców wobec chatbotów jest to, że nieustannie promują one ciągłe zaangażowanie w sposób, który może być uzależniający dla nastolatków, powiedziała: „Bardzo się cieszę, że OpenAI mówi w niektórych odpowiedziach: nie możemy odpowiedzieć na twoje pytanie. Im częściej to zobaczymy, tym bardziej, moim zdaniem, przerwie to cykl prowadzący do wielu niewłaściwych zachowań lub samookaleczeń.”

Niemniej jednak przykłady to tylko tyle: wybrane przypadki, jak zespół ds. bezpieczeństwa OpenAI chciałby, aby modele się zachowywały. Służalczość, czyli tendencja chatbota AI do nadmiernej zgody z użytkownikiem, została wymieniona jako zachowanie zabronione w poprzednich wersjach Model Spec, ale ChatGPT i tak się w to angażował. Było to szczególnie widoczne w przypadku GPT-4o, modelu, który był powiązany z kilkoma przypadkami tego, co eksperci nazywają „psychozą AI”.

Robbie Torney, starszy dyrektor programu AI w Common Sense Media, organizacji non-profit poświęconej ochronie dzieci w cyfrowym świecie, wyraził obawy dotyczące potencjalnych konfliktów w wytycznych Model Spec dla osób poniżej 18 roku życia. Zwrócił uwagę na napięcia między przepisami skoncentrowanymi na bezpieczeństwie a zasadą „żaden temat nie jest zakazany”, która nakazuje modelom podejmowanie każdego tematu, niezależnie od jego wrażliwości.

„Musimy zrozumieć, jak różne części specyfikacji współgrają ze sobą” – powiedział, zauważając, że niektóre sekcje mogą skłaniać systemy do zaangażowania kosztem bezpieczeństwa. Testy jego organizacji wykazały, że ChatGPT często odzwierciedla energię użytkowników, co czasem skutkuje odpowiedziami, które nie są odpowiednie kontekstowo lub nie są zgodne z bezpieczeństwem użytkownika, jak powiedział.

W przypadku Adama Raine’a, nastolatka, który popełnił samobójstwo po miesiącach dialogu z ChatGPT, chatbot angażował się w takie odzwierciedlanie, co pokazują ich rozmowy. Sprawa ta ujawniła również, że API moderacji OpenAI nie zapobiegło niebezpiecznym i szkodliwym interakcjom, mimo że oznaczyło ponad 1000 przypadków, w których ChatGPT wspominał o samobójstwie i 377 wiadomości zawierających treści o samookaleczeniach. Ale to nie wystarczyło, by powstrzymać Adama przed kontynuowaniem rozmów z ChatGPT.

W wywiadzie dla TechCrunch we wrześniu, były badacz ds. bezpieczeństwa OpenAI Steven Adler powiedział, że wynikało to z faktu, iż historycznie OpenAI uruchamiało klasyfikatory (automatyczne systemy oznaczające i flagujące treści) zbiorczo po fakcie, a nie w czasie rzeczywistym, więc nie blokowały one odpowiednio interakcji użytkownika z ChatGPT.

Obecnie OpenAI wykorzystuje automatyczne klasyfikatory do oceny treści tekstowych, obrazowych i dźwiękowych w czasie rzeczywistym, zgodnie z zaktualizowanym dokumentem dotyczącym kontroli rodzicielskiej firmy. Systemy te mają wykrywać i blokować treści związane z materiałami o wykorzystywaniu seksualnym dzieci, filtrować wrażliwe tematy i identyfikować samookaleczenia. Jeśli system oznaczy polecenie sugerujące poważne zagrożenie bezpieczeństwa, mały zespół przeszkolonych osób przeanalizuje oznaczoną treść, aby ustalić, czy są oznaki „ostrego niepokoju”, i może powiadomić rodzica.

Torney pochwalił ostatnie kroki OpenAI w kierunku bezpieczeństwa, w tym transparentność w publikowaniu wytycznych dla użytkowników poniżej 18 roku życia.

„Nie wszystkie firmy publikują swoje wytyczne polityki w ten sam sposób” – powiedział Torney, wskazując na wyciekłe wytyczne Meta, które pokazały, że firma pozwalała swoim chatbotom na prowadzenie zmysłowych i romantycznych rozmów z dziećmi. „To przykład takiej transparentności, która może wspierać badaczy bezpieczeństwa i opinię publiczną w zrozumieniu, jak te modele faktycznie funkcjonują i jak powinny funkcjonować.”

Ostatecznie jednak to rzeczywiste zachowanie systemu AI ma znaczenie, powiedział Adler w czwartek dla TechCrunch.

„Doceniam, że OpenAI przemyślało zamierzone zachowanie, ale jeśli firma nie mierzy rzeczywistych zachowań, intencje pozostają tylko słowami” – powiedział.

Innymi słowy: w tym ogłoszeniu brakuje dowodów na to, że ChatGPT faktycznie przestrzega wytycznych określonych w Model Spec.

Zmiana paradygmatu

Model Spec OpenAI prowadzi ChatGPT do kierowania rozmów z dala od zachęcania do złego postrzegania siebie. Image Credits:OpenAI

Model Spec OpenAI prowadzi ChatGPT do kierowania rozmów z dala od zachęcania do złego postrzegania siebie. Image Credits:OpenAI Eksperci twierdzą, że dzięki tym wytycznym OpenAI wydaje się być gotowe wyprzedzić niektóre przepisy, takie jak kalifornijska ustawa SB 243, niedawno podpisana ustawa regulująca chatboty AI jako towarzyszy, która wejdzie w życie w 2027 roku.

Nowy język Model Spec odzwierciedla niektóre z głównych wymagań tej ustawy dotyczących zakazu angażowania się chatbotów w rozmowy na temat myśli samobójczych, samookaleczeń lub treści o charakterze seksualnym. Ustawa wymaga również, aby platformy co trzy godziny przypominały nieletnim, że rozmawiają z chatbotem, a nie prawdziwą osobą, i że powinni zrobić sobie przerwę.

Zapytany, jak często ChatGPT będzie przypominał nastolatkom, że rozmawiają z chatbotem i prosił ich o zrobienie przerwy, rzecznik OpenAI nie podał szczegółów, mówiąc jedynie, że firma szkoli swoje modele, by przedstawiały się jako AI i przypominały użytkownikom o tym, a także wdraża przypomnienia o przerwach podczas „długich sesji”.

Firma udostępniła również dwa nowe zasoby dotyczące edukacji AI dla rodziców i rodzin. Wskazówki obejmują propozycje rozpoczęcia rozmowy i porady, które pomagają rodzicom rozmawiać z nastolatkami o tym, co AI może, a czego nie może zrobić, budować myślenie krytyczne, ustalać zdrowe granice i poruszać wrażliwe tematy.

W sumie dokumenty formalizują podejście, które dzieli odpowiedzialność z opiekunami: OpenAI precyzuje, co modele powinny robić, a rodzinom oferuje ramy do nadzorowania korzystania z nich.

Skupienie się na odpowiedzialności rodzicielskiej jest godne uwagi, ponieważ odzwierciedla argumenty z Doliny Krzemowej. W swoich rekomendacjach dotyczących federalnej regulacji AI opublikowanych w tym tygodniu, firma VC Andreessen Horowitz zasugerowała więcej wymogów dotyczących ujawniania informacji dla bezpieczeństwa dzieci, zamiast restrykcyjnych wymagań, i większy nacisk na odpowiedzialność rodzicielską.

Kilka zasad OpenAI – bezpieczeństwo na pierwszym miejscu w przypadku konfliktu wartości; kierowanie użytkowników do wsparcia w świecie rzeczywistym; podkreślanie, że chatbot nie jest osobą – jest przedstawianych jako zabezpieczenia dla nastolatków. Jednak kilku dorosłych popełniło samobójstwo i doznało zagrażających życiu urojeń, co rodzi oczywiste pytanie: czy te domyślne ustawienia powinny obowiązywać wszystkich, czy OpenAI traktuje je jako kompromisy, które jest gotowe egzekwować tylko w przypadku nieletnich?

Rzecznik OpenAI odpowiedział, że podejście firmy do bezpieczeństwa ma na celu ochronę wszystkich użytkowników, mówiąc, że Model Spec to tylko jeden z elementów wielowarstwowej strategii.

Li mówi, że jak dotąd panował „trochę Dziki Zachód”, jeśli chodzi o wymagania prawne i intencje firm technologicznych. Ale uważa, że ustawy takie jak SB 243, które wymagają od firm technologicznych publicznego ujawniania zabezpieczeń, zmienią paradygmat.

„Ryzyka prawne pojawią się teraz dla firm, jeśli będą reklamować, że mają te zabezpieczenia i mechanizmy na swojej stronie internetowej, a potem nie wdrożą ich w praktyce” – powiedziała Li. „Bo wtedy, z punktu widzenia powoda, nie patrzysz tylko na standardowe postępowania sądowe czy skargi prawne; patrzysz też na potencjalne skargi dotyczące nieuczciwej, wprowadzającej w błąd reklamy.”