Mula sa liquidation storm hanggang cloud outage: Krisis na sandali para sa crypto infrastructure

Noong ika-20, ang problema sa AWS ng Amazon ay nagdulot ng pagka-paralisa ng Coinbase at dose-dosenang iba pang pangunahing crypto platforms kabilang ang Robinhood, Infura, Base, at Solana.

Orihinal na Pamagat: Crypto Infrastructure is Far From Perfect

Orihinal na May-akda: YQ, crypto KOL

Orihinal na Pagsasalin: AididiaoJP, Foresight News

Muling nakaranas ng malaking pagkaantala ang Amazon Web Services, na malubhang nakaapekto sa crypto infrastructure. Ang problema ng AWS sa US East 1 region (Northern Virginia data center) ay nagdulot ng pagkaparalisa ng Coinbase at dose-dosenang iba pang pangunahing crypto platform kabilang ang Robinhood, Infura, Base, at Solana.

Kinilala na ng AWS ang “pagtaas ng error rate” na nakaapekto sa Amazon DynamoDB at EC2, mga pangunahing database at computing service na umaasa ang libu-libong kumpanya. Ang pagkaantala na ito ay nagbibigay ng agarang at matinding patunay sa sentral na argumento ng artikulong ito: Ang pagdepende ng crypto infrastructure sa centralized cloud service providers ay nagdudulot ng sistemikong kahinaan na paulit-ulit na lumilitaw sa ilalim ng matinding pressure.

Ang timing ay lubhang nakapagbibigay-aral. Sampung araw lamang matapos ilantad ng $1.93 billions na liquidation cascade ang mga failure sa infrastructure sa antas ng trading platform, ipinapakita ng AWS outage ngayon na lumalampas na ang problema sa isang platform at umaabot na sa foundational cloud infrastructure layer. Kapag nagkaaberya ang AWS, sabay-sabay na naaapektuhan ang centralized trading platforms, mga “decentralized” platform na may centralized dependencies, at napakaraming iba pang serbisyo.

Hindi ito isang isolated na insidente, kundi isang pattern. Ang sumusunod na pagsusuri ay nagdodokumento ng mga katulad na AWS outage noong Abril 2025, Disyembre 2021, at Marso 2017, na bawat isa ay nagdulot ng pagkaparalisa ng pangunahing crypto services. Ang tanong ay hindi kung mangyayari muli ang susunod na infrastructure failure, kundi kailan ito mangyayari at ano ang magiging trigger.

Liquidation Cascade noong Oktubre 10-11, 2025: Isang Case Study

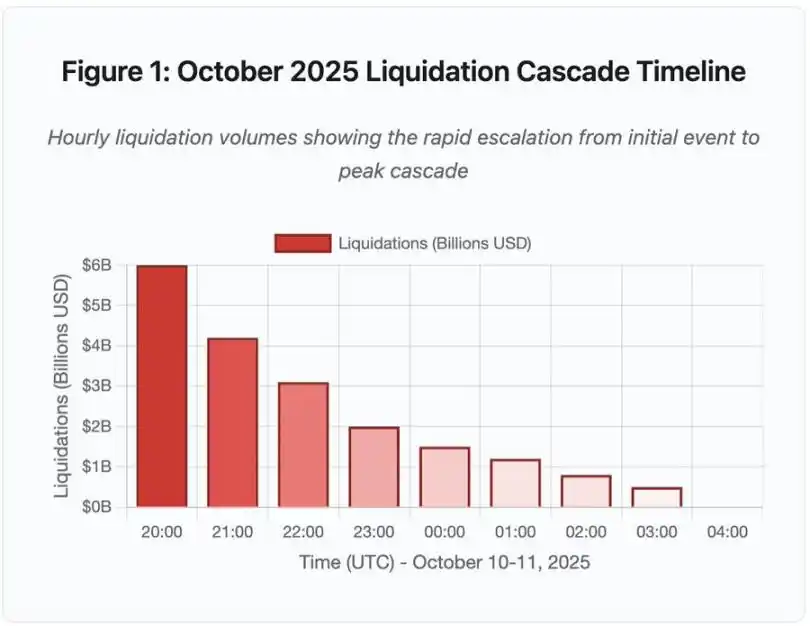

Ang liquidation cascade noong Oktubre 10-11, 2025 ay nagbibigay ng isang makabuluhang case study sa pattern ng infrastructure failure. Sa 20:00 UTC, isang mahalagang geopolitical announcement ang nag-trigger ng malawakang pagbebenta sa market. Sa loob ng isang oras, nagkaroon ng $6 billions na liquidation. Pagsapit ng bukas ng Asian market, $19.3 billions na leveraged positions mula sa 1.6 milyong trader accounts ang naglaho.

Figure 1: Timeline ng Liquidation Cascade noong Oktubre 2025

Ipinapakita ng interactive timeline chart na ito ang dramatikong pag-usad ng liquidation kada oras. Sa unang oras pa lang, $6 billions na agad ang naglaho, at mas matindi pa ang naging epekto sa ikalawang oras ng cascade acceleration. Ang visualization ay nagpapakita ng:

· 20:00-21:00: Inisyal na shock – $6 billions ang na-liquidate (pulang area)

· 21:00-22:00: Peak ng cascade – $4.2 billions, dito nagsimulang mag-rate limit ang API

· 22:00-04:00: Patuloy na paglala – $9.1 billions ang na-liquidate sa manipis na market liquidity

· Kritikal na turning point: API rate limiting, pag-atras ng market makers, pagnipis ng order book

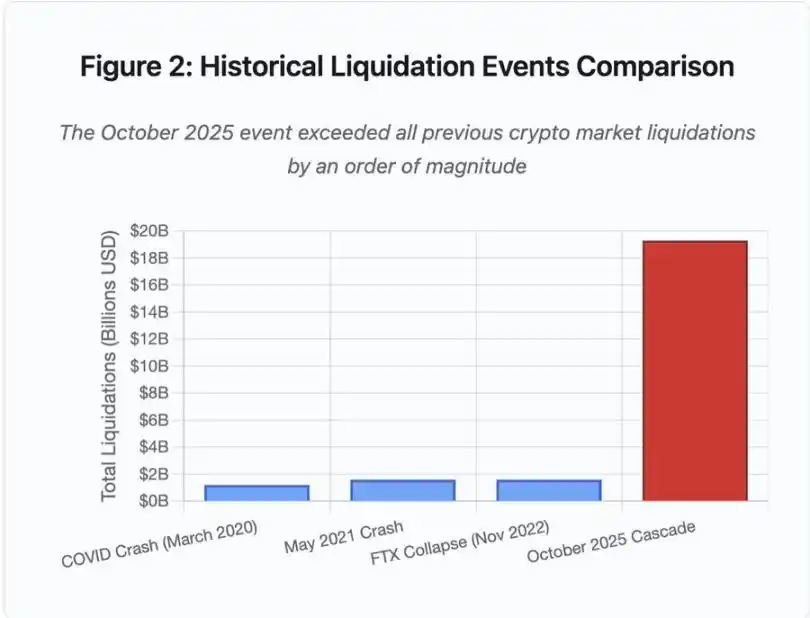

Ang laki nito ay hindi bababa sa isang order of magnitude na mas malaki kaysa sa anumang naunang crypto market event, at ipinapakita ng historical comparison ang step function nature ng insidenteng ito:

Figure 2: Paghahambing ng Historical Liquidation Events

Ang bar chart ay dramatikong nagpapakita ng prominence ng event noong Oktubre 2025:

· Marso 2020 (COVID): $1.2 billions

· Mayo 2021 (crash): $1.6 billions

· Nobyembre 2022 (FTX): $1.6 billions

· Oktubre 2025: $19.3 billions, 16x na mas malaki kaysa sa dating record

Ngunit ang liquidation numbers ay bahagi lamang ng kuwento. Mas mahalagang tanong ang mekanismo: Paano nag-trigger ang external market event ng ganitong partikular na failure pattern? Ang sagot ay nagpapakita ng systemic weaknesses sa centralized trading platform infrastructure at blockchain protocol design.

Off-chain Failures: Arkitektura ng Centralized Trading Platforms

Infrastructure Overload at Rate Limiting

Ang mga trading platform API ay nagpapatupad ng rate limits upang maiwasan ang abuse at pamahalaan ang server load. Sa normal na operasyon, pinapayagan ng mga limitasyong ito ang lehitimong trading habang pinipigilan ang potensyal na pag-atake. Ngunit sa panahon ng matinding volatility, kapag libu-libong trader ang sabay-sabay na sumusubok mag-adjust ng kanilang positions, ang parehong rate limits na ito ay nagiging bottleneck.

Nililimitahan ng CEX ang liquidation notifications sa isang order kada segundo, kahit pa libo-libong orders ang pinoproseso kada segundo. Sa panahon ng cascade event noong Oktubre, nagdulot ito ng kawalan ng transparency. Hindi matukoy ng users ang real-time severity ng cascade. Ang third-party monitoring tools ay nagpapakita ng daan-daang liquidation kada minuto, ngunit mas mababa ang ipinapakita ng opisyal na data sources.

Pinipigilan ng API rate limits ang mga trader na magbago ng kanilang positions sa kritikal na unang oras, nagti-timeout ang connection requests, at nabibigo ang order submissions. Hindi na-execute ang stop-loss orders, at ang position queries ay bumabalik ng luma nang data. Ang infrastructure bottleneck na ito ay nagko-convert ng market event sa isang operational crisis.

Ang mga tradisyonal na trading platform ay nagko-configure ng infrastructure na may safety margin para sa normal load. Ngunit magkaiba ang normal load at stress load, at hindi mahusay na naipapakita ng average daily volume ang peak stress demand. Sa panahon ng cascade event, ang trading volume ay sumirit ng 100x o higit pa, at ang queries sa position data ay tumaas ng 1000x, dahil sabay-sabay na chine-check ng bawat user ang kanilang account.

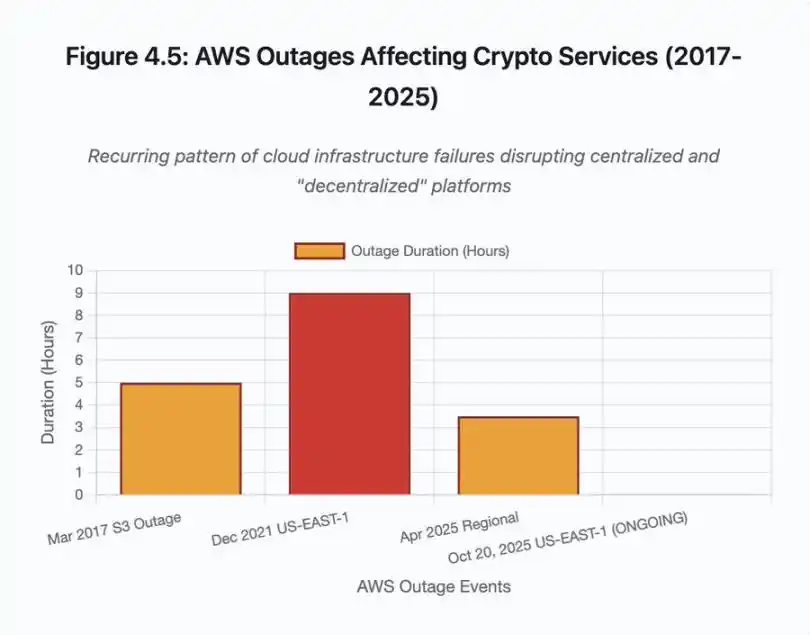

Figure 4.5: Epekto ng AWS Outage sa Crypto Services

Ang auto-scaling cloud infrastructure ay nakakatulong, ngunit hindi ito agad-agad tumutugon; ilang minuto ang kailangan para mag-spin up ng karagdagang database read replicas. Ilang minuto rin ang kailangan para mag-create ng bagong API gateway instances. Sa mga minutong iyon, patuloy na ginagamit ng margin system ang sira at overloaded na order book price data sa pagma-mark ng position value.

Oracle Manipulation at Pricing Vulnerabilities

Sa panahon ng cascade event noong Oktubre, naging malinaw ang isang kritikal na design choice sa margin system: ilang trading platform ang gumagamit ng internal spot market price sa halip na external oracle data stream para kalkulahin ang collateral value. Sa normal na market conditions, pinananatili ng arbitrageurs ang price consistency sa pagitan ng venues. Ngunit kapag under stress ang infrastructure, bumabagsak ang coupling na ito.

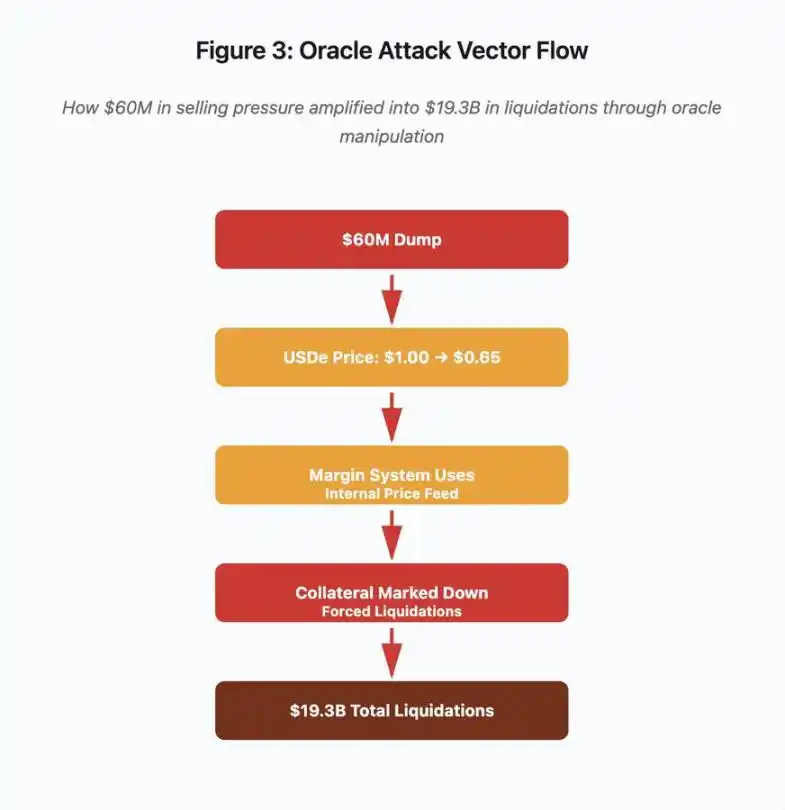

Figure 3: Oracle Manipulation Flowchart

Ipinapakita ng interactive flowchart na ito ang limang yugto ng attack vector:

· Inisyal na pagbebenta: $60 millions na selling pressure sa USDe

· Manipulasyon ng presyo: USDe bumagsak mula $1.00 hanggang $0.65 sa isang exchange

· Oracle failure: Margin system ay gumagamit ng sira na internal price data stream

· Cascade trigger: Collateral ay na-downgrade ang value, nagsimula ang forced liquidation

· Amplification: Kabuuang $19.3 billions na liquidation (322x amplification)

Sinamantala ng attack na ito ang setting ng Binance na gumamit ng spot market price para sa wrapped synthetic collateral. Nang ibinenta ng attacker ang $60 millions na USDe sa manipis na order book, bumagsak ang spot price mula $1.00 hanggang $0.65. Ang margin system na naka-configure na magmarka ng collateral ayon sa spot price ay nag-downgrade ng 35% sa lahat ng USDe-collateralized positions. Nag-trigger ito ng margin calls at forced liquidations sa libu-libong accounts.

Pinilit ng mga liquidation na ito ang mas maraming sell orders sa parehong illiquid market, na lalong nagbaba ng presyo. Nakita ng margin system ang mas mababang presyo at minarkahan ang mas maraming positions, kaya ang feedback loop ay nagpalaki ng $60 millions na selling pressure sa $19.3 billions na forced liquidation.

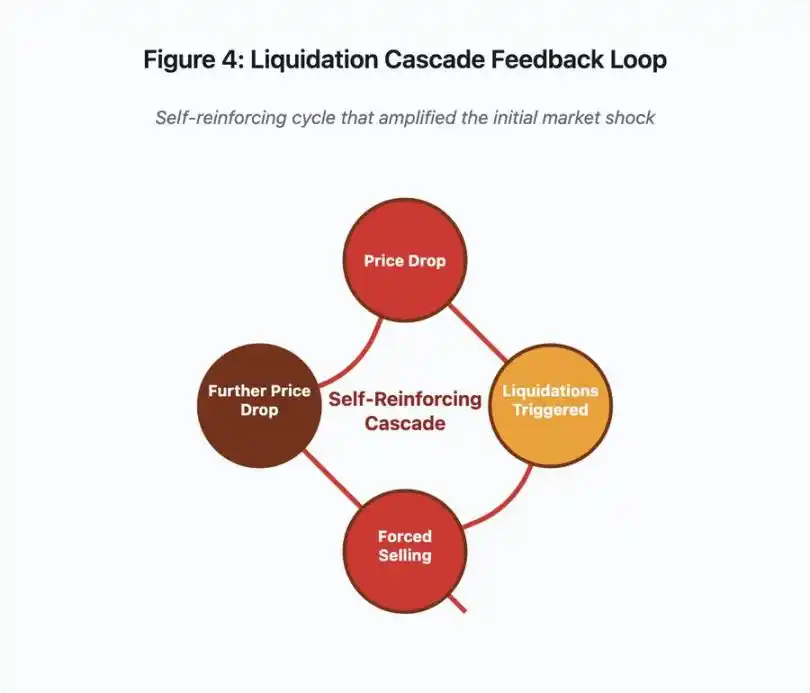

Figure 4: Liquidation Cascade Feedback Loop

Ipinapaliwanag ng feedback loop chart na ito ang self-reinforcing nature ng cascade:

Bagsak ang presyo → na-trigger ang liquidation → forced selling → lalong bumagsak ang presyo → [cycle repeats]

Kung gumamit ng maayos na disenyo ng oracle system, hindi sana gumana ang mekanismong ito. Kung gumamit ang Binance ng time-weighted average price (TWAP) mula sa maraming trading platform, hindi maaapektuhan ng instant price manipulation ang collateral valuation. Kung gumamit sila ng aggregated price data stream mula sa Chainlink o iba pang multi-source oracle, mabibigo ang attack.

Apat na araw bago nito, ipinakita ng wBETH event ang katulad na kahinaan. Dapat ay 1:1 ang redemption ratio ng wBETH sa ETH. Sa panahon ng cascade event, naubos ang liquidity at nagpakita ng 20% discount ang wBETH/ETH spot market. Binaba ng margin system ang valuation ng wBETH collateral, kaya na-liquidate ang mga positions na fully collateralized ng underlying ETH.

Auto-Deleveraging (ADL) Mechanism

Kapag hindi maisagawa ang liquidation sa kasalukuyang market price, nagpapatupad ang trading platform ng auto-deleveraging (ADL) na ipinapasa ang losses sa mga kumikitang trader. Ang ADL ay sapilitang nagsasara ng mga winning positions sa kasalukuyang presyo upang punan ang gap ng liquidated positions.

Sa panahon ng cascade event noong Oktubre, nagpatupad ang Binance ng ADL sa maraming trading pairs. Ang mga trader na may winning long positions ay sapilitang na-close ang kanilang trades, hindi dahil sa sarili nilang risk management failure, kundi dahil naging insolvent ang positions ng ibang trader.

Ipinapakita ng ADL ang isang pangunahing architectural choice sa centralized derivatives trading. Tinitiyak ng trading platform na hindi sila malulugi. Ibig sabihin, kailangang akuin ang losses ng isa o higit pang partido:

· Insurance fund (pondo ng platform para punan ang liquidation gap)

· ADL (sapilitang pagsasara ng winning traders)

· Socialized losses (pagpapasa ng losses sa lahat ng users)

Ang laki ng insurance fund kumpara sa open interest ang nagtatakda ng frequency ng ADL. Noong Oktubre 2025, may $2 billions ang insurance fund ng Binance. Kumpara sa $4 billions open interest ng BTC, ETH, at BNB perpetual contracts, ito ay 50% coverage. Ngunit sa panahon ng cascade event, umabot sa mahigit $20 billions ang total open interest sa lahat ng trading pairs. Hindi sapat ang insurance fund para punan ang gap.

Pagkatapos ng cascade event noong Oktubre, inanunsyo ng Binance na kapag nanatili sa ilalim ng $4 billions ang total open interest, ginagarantiya nilang walang ADL sa BTC, ETH, at BNB USDⓈ-M contracts. Lumilikha ito ng incentive structure: Maaaring panatilihin ng platform ang mas malaking insurance fund para maiwasan ang ADL, ngunit nangangahulugan ito ng pag-freeze ng capital na puwedeng gamitin sa kita.

On-chain Failures: Mga Limitasyon ng Blockchain Protocols

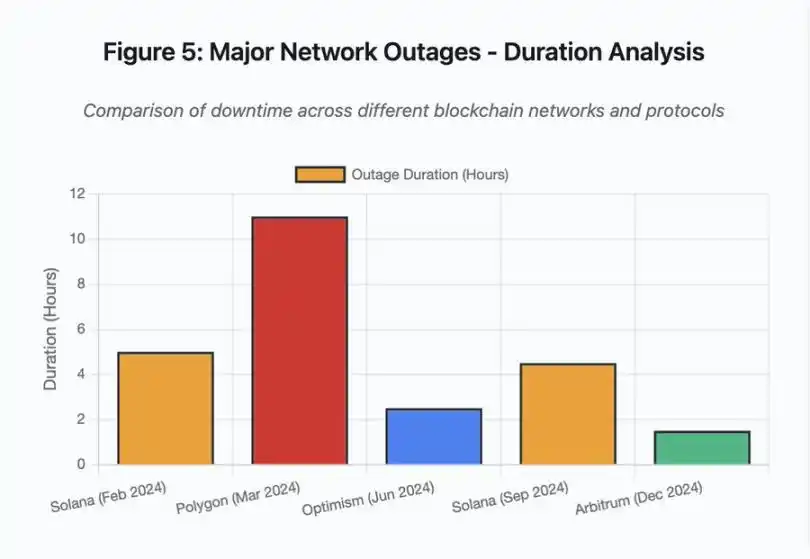

Ikinukumpara ng bar chart ang downtime sa iba’t ibang events:

· Solana (Pebrero 2024): 5 oras – bottleneck sa vote throughput

· Polygon (Marso 2024): 11 oras – validator version mismatch

· Optimism (Hunyo 2024): 2.5 oras – sequencer overload (airdrop)

· Solana (Setyembre 2024): 4.5 oras – spam attack sa transactions

· Arbitrum (Disyembre 2024): 1.5 oras – RPC provider failure

Figure 5: Major Network Outages – Duration Analysis

Solana: Consensus Bottleneck

Naranasan ng Solana ang maraming outage noong 2024-2025. Ang outage noong Pebrero 2024 ay tumagal ng halos 5 oras, at ang outage noong Setyembre 2024 ay tumagal ng 4-5 oras. Pareho ang root cause: Hindi kayang i-handle ng network ang transaction volume sa panahon ng spam attack o extreme activity.

Detalye ng Figure 5: Ang outages ng Solana (5 oras noong Pebrero, 4.5 oras noong Setyembre) ay nagpapakita ng paulit-ulit na isyu sa network resilience sa ilalim ng pressure.

Ang arkitektura ng Solana ay optimized para sa throughput. Sa ideal na kondisyon, kayang magproseso ng network ng 3,000-5,000 transactions kada segundo na may sub-second finality. Mas mataas ito ng ilang order of magnitude kaysa Ethereum. Ngunit sa panahon ng stress events, nagdudulot ng kahinaan ang optimization na ito.

Ang outage noong Setyembre 2024 ay dulot ng spam transaction flood na nag-overwhelm sa voting mechanism ng validators. Kailangang bumoto ang Solana validators sa mga blocks para makamit ang consensus. Sa normal na operasyon, inuuna ng validators ang vote transactions para matiyak ang consensus progress. Ngunit dati, tinuturing ng protocol ang vote transactions na katulad ng regular transactions sa fee market.

Kapag napuno ng milyun-milyong spam transactions ang mempool, nahihirapan ang validators na maipadala ang vote transactions. Kung kulang ang votes, hindi ma-finalize ang blocks. Kung walang finalized blocks, titigil ang chain. Ang mga user na may pending transactions ay makikita itong nakatengga sa mempool. Hindi rin makapag-submit ng bagong transactions.

Naitala ng StatusGator ang maraming Solana service outages noong 2024-2025, ngunit hindi ito opisyal na kinilala ng Solana. Nagdudulot ito ng information asymmetry. Hindi matukoy ng users kung local connection issue lang o buong network outage. Nagbibigay ng accountability ang third-party monitoring services, ngunit dapat ay may comprehensive status page ang platform.

Ethereum: Gas Fee Explosion

Naranasan ng Ethereum ang matinding pagtaas ng Gas fees noong DeFi boom ng 2021, kung saan ang simpleng transfer ay umaabot ng higit $100. Ang complex smart contract interactions ay umaabot ng $500-$1,000. Ginawang hindi magamit ang network para sa maliliit na transactions, at nagbukas ng bagong attack vector: MEV extraction.

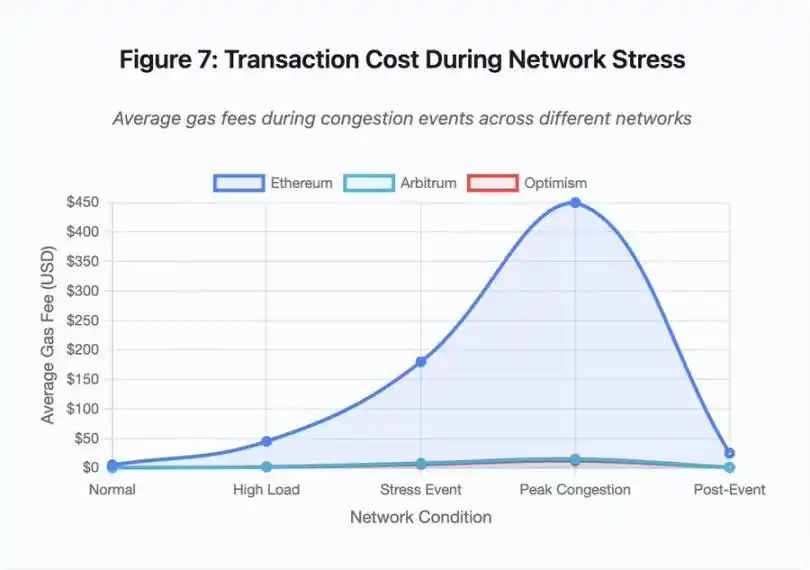

Figure 7: Transaction Costs sa Panahon ng Network Stress

Ipinapakita ng line chart na ito ang dramatikong pagtaas ng Gas fees sa panahon ng stress events:

· Ethereum: $5 (normal) → $450 (peak congestion) – 90x increase

· Arbitrum: $0.50 → $15 – 30x increase

· Optimism: $0.30 → $12 – 40x increase

Ipinapakita ng visualization na kahit ang Layer 2 solutions ay nakakaranas ng malaking pagtaas ng Gas fees, kahit na mas mababa ang starting point.

Ang maximum extractable value (MEV) ay tumutukoy sa kita na maaaring makuha ng validators sa pamamagitan ng pag-reorder, pag-include, o pag-exclude ng transactions. Sa high Gas fee environment, nagiging napaka-lucrative ng MEV. Nag-uunahan ang arbitrageurs na ma-front-run ang malalaking DEX trades, at nag-uunahan ang liquidation bots na mauna sa pag-liquidate ng undercollateralized positions. Ang kompetisyong ito ay nagreresulta sa Gas fee bidding wars.

Ang mga user na gustong masiguradong ma-include ang kanilang transaction sa panahon ng congestion ay kailangang mag-bid ng mas mataas kaysa sa MEV bots. Nagdudulot ito ng sitwasyon kung saan mas mataas ang transaction fee kaysa sa value ng transaction. Gusto mong kunin ang iyong $100 airdrop? Magbayad ng $150 na Gas fee. Kailangan mong magdagdag ng collateral para maiwasan ang liquidation? Makipagkumpitensya sa bots na nagbabayad ng $500 priority fee.

Ang Gas limit ng Ethereum ay naglilimita sa total computation kada block. Sa panahon ng congestion, naglalaban-laban ang users para sa scarce block space. Gumagana ang fee market ayon sa disenyo: Ang mas mataas ang bid, mas may priority. Ngunit ang disenyo na ito ay nagdudulot ng mas mataas na gastos sa panahon ng mataas na paggamit—eksaktong panahon na pinaka-kailangan ng users ng access.

Sinusubukan ng Layer 2 solutions na solusyunan ito sa pamamagitan ng paglipat ng computation off-chain, habang regular na nagse-settle sa Ethereum para sa security. Ang Optimism, Arbitrum, at iba pang Rollup ay nagpoproseso ng libu-libong transactions off-chain, tapos ay nagpo-post ng compressed proofs sa Ethereum. Sa normal na operasyon, matagumpay nitong binababa ang per-transaction cost.

Layer 2: Sequencer Bottleneck

Ngunit nagdadala ng bagong bottleneck ang Layer 2 solutions. Noong Hunyo 2024, naranasan ng Optimism ang outage nang sabay-sabay na nag-claim ng airdrop ang 250,000 addresses. Hindi kinaya ng sequencer—ang component na nagso-sort ng transactions bago isumite sa Ethereum—ang load, kaya ilang oras na hindi makapag-submit ng transaction ang users.

Ipinapakita ng outage na ang paglipat ng computation off-chain ay hindi nag-aalis ng infrastructure demand. Kailangang i-handle ng sequencer ang incoming transactions, i-sort, i-execute, at gumawa ng fraud proofs o ZK proofs para sa Ethereum settlement. Sa extreme traffic, nahaharap ang sequencer sa parehong scaling challenges ng independent blockchain.

Kailangang may redundancy sa RPC providers. Kung pumalya ang main provider, dapat seamless ang failover ng users sa alternatibo. Sa Optimism outage, may ilang RPC providers na gumana, ngunit ang iba ay pumalya. Ang mga wallet na default na nakakonekta sa pumalyang provider ay hindi makapag-interact sa chain, kahit online pa ang chain mismo.

Paulit-ulit na pinatunayan ng AWS outages ang centralized infrastructure risk sa crypto ecosystem:

· Oktubre 20, 2025 (ngayon): Naapektuhan ng US East 1 outage ang Coinbase, pati na ang Venmo, Robinhood, at Chime. Kinilala ng AWS ang pagtaas ng error rate sa DynamoDB at EC2 services.

· Abril 2025: Naapektuhan ng regional outage nang sabay-sabay ang Binance, KuCoin, at MEXC. Naging unavailable ang maraming major exchanges nang pumalya ang kanilang AWS-hosted components.

· Disyembre 2021: Nagdulot ng 8-9 na oras na outage sa Coinbase, Binance.US, at “decentralized” exchange na dYdX ang US East 1 outage, pati na rin ang Amazon’s own warehouses at major streaming services.

· Marso 2017: Pinigilan ng S3 outage ang users na mag-login sa Coinbase at GDAX nang limang oras, kasabay ng malawakang internet outage.

Malinaw ang pattern: Ang mga trading platform na ito ay nagho-host ng critical components sa AWS infrastructure. Kapag nagkaroon ng regional outage ang AWS, sabay-sabay na nagiging unavailable ang maraming major trading platforms at services. Hindi ma-access ng users ang kanilang pondo, hindi makapag-trade, o makapag-modify ng positions sa panahon ng outage—eksaktong panahon na maaaring kailanganin ng agarang aksyon dahil sa market volatility.

Polygon: Consensus Version Mismatch

Naranasan ng Polygon (dating Matic) ang 11-oras na outage noong Marso 2024. Ang root cause ay validator version mismatch—may ilang validator na gumagamit ng lumang software version, habang ang iba ay naka-upgrade na. Magkaiba ang paraan ng pag-compute ng state transitions ng mga bersyon na ito.

Detalye ng Figure 5: Ang Polygon outage (11 oras) ang pinakamahaba sa mga major events na na-analisa, na nagpapakita ng grabeng epekto ng consensus failure.

Kapag nagkaiba ng conclusion ang validators tungkol sa tamang state, nabibigo ang consensus at hindi makapag-produce ng bagong blocks ang chain dahil hindi magkasundo ang validators sa block validity. Nagdudulot ito ng deadlock: Ang validators na gumagamit ng lumang software ay tinatanggihan ang blocks mula sa bagong software, at vice versa.

Kailangan ng coordination ng validator upgrades para maresolba ito, ngunit matagal gawin ito sa panahon ng outage. Kailangang kontakin ang bawat validator operator, i-deploy ang tamang software version, at i-restart ang kanilang validator. Sa isang decentralized network na may daan-daang independent validators, maaaring tumagal ng ilang oras o araw ang ganitong coordination.

Karaniwan, ginagamit ang block height trigger para sa hard fork. Lahat ng validator ay nag-u-upgrade bago ang specific block height para sabay-sabay ang activation, ngunit nangangailangan ito ng advance coordination. Ang incremental upgrades—kung saan unti-unting nag-a-adopt ng bagong version ang validators—ay may risk ng eksaktong version mismatch na nagdulot ng Polygon outage.

Architectural Trade-offs

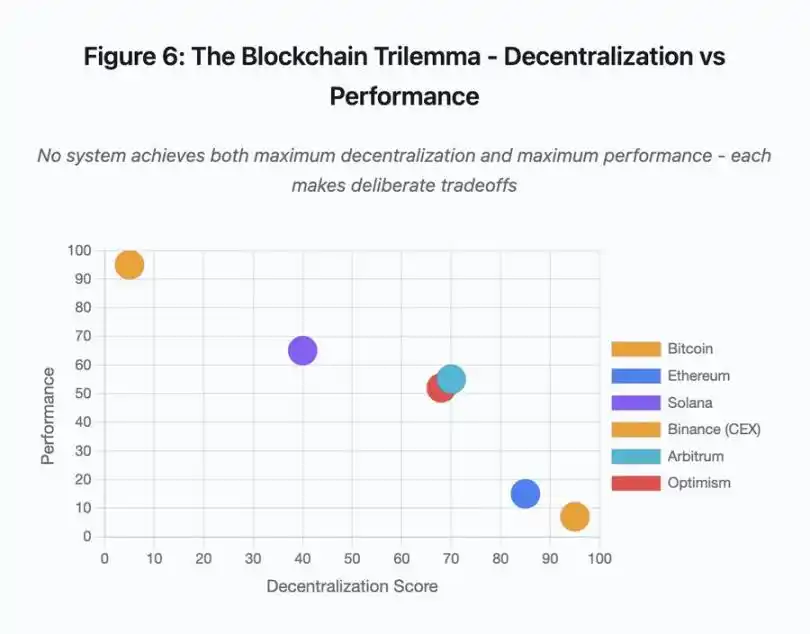

Figure 6: Blockchain Trilemma – Decentralization vs Performance

Ipinapakita ng scatter plot na ito ang mapping ng iba’t ibang system sa dalawang pangunahing dimensyon:

· Bitcoin: Mataas ang decentralization, mababa ang performance

· Ethereum: Mataas ang decentralization, katamtamang performance

· Solana: Katamtamang decentralization, mataas na performance

· Binance (CEX): Minimal ang decentralization, maximum ang performance

· Arbitrum/Optimism: Katamtamang mataas ang decentralization, katamtamang performance

Pangunahing insight: Walang system na sabay na nakakamit ang maximum decentralization at maximum performance; bawat disenyo ay may pinag-isipang trade-off para sa iba’t ibang use case.

Ang centralized trading platforms ay nakakamit ang low latency sa pamamagitan ng architectural simplicity—ang matching engine ay nagpoproseso ng orders sa microseconds, at ang state ay nasa centralized database. Walang consensus protocol overhead, ngunit ang simplicity na ito ay lumilikha ng single point of failure, at kapag under stress ang infrastructure, mabilis na kumakalat ang cascading failures sa tightly coupled systems.

Ang decentralized protocols ay nagdi-distribute ng state sa validators, inaalis ang single point of failure. Ang high-throughput chains ay nananatili ang property na ito kahit sa panahon ng outage (walang loss of funds, pansamantalang nawawala lang ang liveness). Ngunit ang consensus sa pagitan ng distributed validators ay nagdadagdag ng computational overhead—kailangang magkasundo ang validators bago ma-finalize ang state transitions. Kapag nagka-incompatible version ang validators o sobrang dami ng traffic, maaaring pansamantalang tumigil ang consensus process.

Ang pagdagdag ng replicas ay nagpapataas ng fault tolerance ngunit nagpapataas din ng coordination cost. Sa Byzantine fault-tolerant systems, bawat karagdagang validator ay nagpapataas ng communication overhead. Ang high-throughput architectures ay nag-o-optimize ng validator communication para ma-minimize ang overhead at makamit ang mataas na performance, ngunit nagiging vulnerable sa ilang attack patterns. Ang security-focused architectures ay inuuna ang validator diversity at consensus robustness, nililimitahan ang base layer throughput habang pinapalaki ang resilience.

Sinusubukan ng Layer 2 solutions na pagsamahin ang parehong properties sa pamamagitan ng layered design. Namamana nila ang security properties ng Ethereum L1 settlement, habang nagbibigay ng high throughput sa pamamagitan ng off-chain computation. Ngunit nagdadagdag sila ng bagong bottlenecks sa sequencer at RPC layer, na nagpapakita na ang architectural complexity ay lumilikha ng bagong failure modes habang nilulutas ang iba.

Scalability pa rin ang Root Problem

Ipinapakita ng mga event na ito ang consistent pattern: Ang mga system ay naka-configure para sa normal load, tapos ay catastrophic na nabibigo sa ilalim ng stress. Epektibong nahahandle ng Solana ang regular traffic, ngunit bumabagsak kapag tumaas ng 10,000% ang transaction volume. Nanatiling reasonable ang Ethereum Gas fees hanggang nagdulot ng congestion ang DeFi adoption. Maayos ang infrastructure ng Optimism hanggang sabay-sabay na nag-claim ng airdrop ang 250,000 addresses. Gumagana nang maayos ang Binance API sa normal trading, ngunit nagiging bottleneck sa panahon ng liquidation cascade.

Ipinakita ng event noong Oktubre 2025 ang dynamic na ito sa exchange level. Sa normal na operasyon, sapat ang API rate limits at database connections ng Binance, ngunit sa panahon ng liquidation cascade, kapag sabay-sabay na nag-a-adjust ng positions ang bawat trader, nagiging bottleneck ang mga limitasyong ito. Ang margin system na idinisenyo para protektahan ang exchange sa pamamagitan ng forced liquidation ay nagpalala ng krisis sa pamamagitan ng paglikha ng forced sellers sa pinakamasamang panahon.

Hindi sapat ang auto-scaling para protektahan laban sa step-function load increases. Ilang minuto ang kailangan para mag-spin up ng karagdagang servers, at sa mga minutong iyon, ginagamit ng margin system ang sira at manipis na order book price data sa pagma-mark ng position value. Pagdating ng bagong capacity, kumalat na ang chain reaction.

Ang over-provisioning ng resources para sa rare stress events ay magastos sa normal na operasyon. Ang mga exchange operators ay nag-o-optimize para sa typical load at tinatanggap ang occasional failures bilang economically rational choice. Ang cost ng downtime ay naipapasa sa users, na nakakaranas ng liquidation, stuck trades, o hindi ma-access ang funds sa panahon ng critical market moves.

Mga Pagpapabuti sa Infrastructure

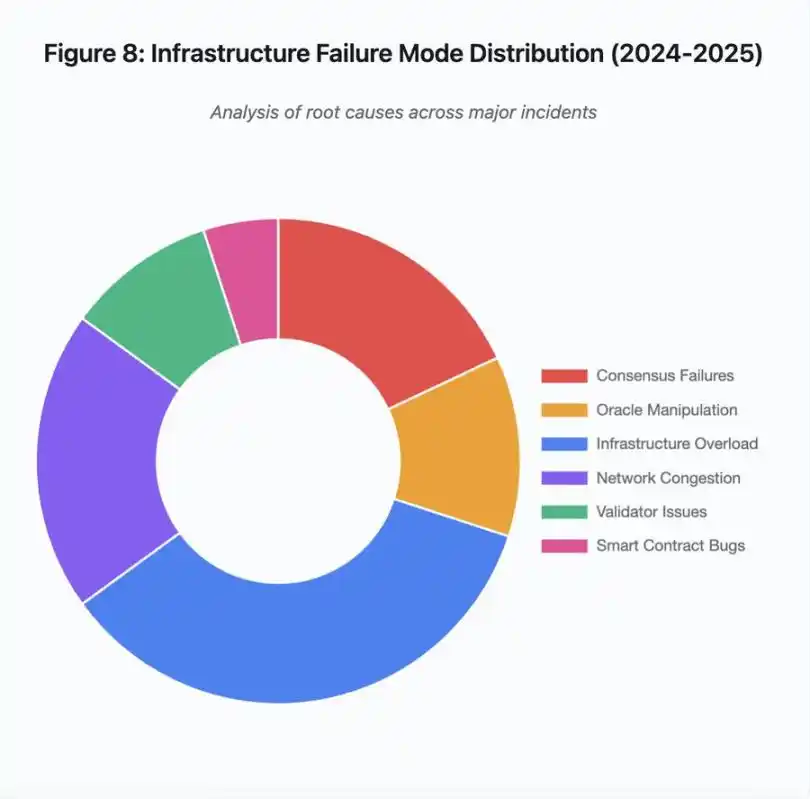

Figure 8: Distribution ng Infrastructure Failure Modes (2024-2025)

Ipinapakita ng pie chart breakdown ng root causes:

· Infrastructure overload: 35% (pinakakaraniwan)

· Network congestion: 20%

· Consensus failure: 18%

· Oracle manipulation: 12%

· Validator issues: 10%

· Smart contract vulnerabilities: 5%

Ilang architectural changes ang maaaring magpababa ng frequency at severity ng failures, bagama’t bawat isa ay may kaakibat na trade-off:

Paghihiwalay ng Pricing System at Liquidation System

Bahagi ng problema noong Oktubre ay ang coupling ng margin calculation sa spot market price. Ang paggamit ng redemption ratio sa halip na spot price para sa wrapped assets ay maaaring nakaiwas sa maling pricing ng wBETH. Mas pangkalahatan, hindi dapat umasa ang critical risk management systems sa market data na maaaring manipulahin. Ang independent oracle systems na may multi-source aggregation at TWAP computation ay nagbibigay ng mas matatag na price data stream.

Over-provisioned at Redundant Infrastructure

Ipinakita ng AWS outage noong Abril 2025 na nakaapekto sa Binance, KuCoin, at MEXC ang panganib ng centralized infrastructure dependency. Ang pagpapatakbo ng critical components sa maraming cloud providers ay nagpapataas ng operational complexity at cost, ngunit inaalis ang correlated failures. Maaaring mag-maintain ng maraming RPC providers na may automatic failover ang Layer 2 networks. Mukhang sayang ang dagdag na gastos sa normal na operasyon, ngunit nakakaiwas ito sa multi-hour downtime sa panahon ng peak demand.

Mas Pinahusay na Stress Testing at Capacity Planning

Ipinapakita ng pattern na “gumagana nang maayos hanggang mag-fail” na kulang ang testing sa ilalim ng stress. Dapat standard practice ang pagsubok ng 100x normal load—mas mura ang tukuyin ang bottleneck sa development kaysa matuklasan ito sa aktwal na outage. Ngunit mahirap pa rin ang realistic load testing. Ang production traffic ay nagpapakita ng patterns na hindi kayang gayahin ng synthetic tests, at iba ang behavior ng users sa aktwal na crash kaysa sa testing.

Ang Landas Pasulong

Ang over-provisioning ang pinaka-maaasahang solusyon, ngunit salungat ito sa economic incentives. Ang pagpapanatili ng 10x excess capacity para sa rare events ay araw-araw na gastos para maiwasan ang problemang nangyayari isang beses sa isang taon. Hanggang hindi sapat ang cost ng catastrophic failure para bigyang-katwiran ang over-provisioning, patuloy na mabibigo ang mga system sa ilalim ng stress.

Maaaring pilitin ng regulatory pressure ang pagbabago. Kung ipag-uutos ng regulasyon ang 99.9% uptime o limitahan ang acceptable downtime, mapipilitan ang mga trading platform na mag-over-provision. Ngunit kadalasan, sumusunod lang ang regulasyon pagkatapos ng disaster, hindi bago ito mangyari. Ang pagbagsak ng Mt. Gox noong 2014 ang nagtulak sa Japan na magpatupad ng formal crypto exchange regulation. Malamang na magdulot ng katulad na regulatory response ang cascade event noong Oktubre 2025. Hindi pa tiyak kung magiging outcome-based (max acceptable downtime, max slippage during liquidation) o prescriptive (specific oracle providers, circuit breaker thresholds) ang mga tugon na ito.

Ang pangunahing hamon ay ang mga system na ito ay tumatakbo 24/7 sa global market ngunit umaasa sa infrastructure na idinisenyo para sa tradisyonal na business hours. Kapag nangyari ang stress sa 02:00, nagmamadali ang mga team na mag-deploy ng fix habang patuloy na lumalaki ang losses ng users. Sa tradisyonal na market, itinitigil ang trading sa panahon ng stress; sa crypto market, bumabagsak lang ang system. Kung ito ay feature o bug ay depende sa pananaw at posisyon.

Ang blockchain systems ay nakamit ang kahanga-hangang technical complexity sa maikling panahon. Ang pagpapanatili ng distributed consensus sa libu-libong nodes ay tunay na engineering achievement. Ngunit ang pagiging maaasahan sa ilalim ng stress ay nangangailangan ng paglipat mula sa prototype architecture patungo sa production-grade infrastructure. Nangangailangan ito ng investment at ng pagpapahalaga sa robustness kaysa sa bilis ng feature development.

Ang hamon ay kung paano uunahin ang robustness kaysa sa growth sa panahon ng bull market, kapag lahat ay kumikita at tila problema ng iba ang downtime. Kapag hinintay ang susunod na cycle para i-stress test ang system, lilitaw ang mga bagong kahinaan. Matututo ba ang industriya mula sa Oktubre 2025, o uulitin ang parehong pattern ay nananatiling bukas na tanong. Ipinapakita ng kasaysayan na matutuklasan natin ang susunod na critical vulnerability sa pamamagitan ng isa pang multi-billion dollar failure sa ilalim ng stress.

Disclaimer: Ang nilalaman ng artikulong ito ay sumasalamin lamang sa opinyon ng author at hindi kumakatawan sa platform sa anumang kapasidad. Ang artikulong ito ay hindi nilayon na magsilbi bilang isang sanggunian para sa paggawa ng mga desisyon sa investment.

Baka magustuhan mo rin

Kapag Hindi na Kailangan ng Ethereum ang "Re-execution": Ang Rebolusyon ng Real-time na Patunay ng Brevis Pico

Mula sa paulit-ulit na pagpapatupad hanggang sa mabilisang beripikasyon, isang rebolusyong nakatago sa likod ng graphics card ang kasalukuyang binabago ang pundasyon ng blockchain.

Paano matukoy ang bull at bear market traps sa crypto bago ka mahuli ng mga ito

Mga prediksyon sa presyo 10/22: BTC, ETH, BNB, XRP, SOL, DOGE, ADA, HYPE, LINK, XLM

Gustong tumaas ng Bitcoin, pero hindi nakakatulong ang mga taripa ni Trump: Mag-TACO ba ulit ang administrasyon?