Nel suo ultimo sforzo per affrontare le crescenti preoccupazioni sull'impatto dell'AI sui giovani, OpenAI ha aggiornato giovedì le sue linee guida su come i suoi modelli di AI dovrebbero comportarsi con utenti sotto i 18 anni e ha pubblicato nuove risorse di alfabetizzazione all'AI per adolescenti e genitori. Tuttavia, rimangono domande su quanto coerentemente tali politiche verranno applicate nella pratica.

Gli aggiornamenti arrivano mentre l'industria dell'AI in generale, e OpenAI in particolare, affrontano un controllo crescente da parte di legislatori, educatori e sostenitori della sicurezza dei minori dopo che diversi adolescenti sarebbero morti per suicidio dopo lunghe conversazioni con chatbot AI.

La Gen Z, che include coloro nati tra il 1997 e il 2012, è il gruppo di utenti più attivo del chatbot di OpenAI. E a seguito dell'accordo recente tra OpenAI e Disney, è probabile che sempre più giovani si avvicinino alla piattaforma, che permette di fare tutto, dal chiedere aiuto per i compiti a generare immagini e video su migliaia di argomenti.

La settimana scorsa, 42 procuratori generali statali hanno firmato una lettera indirizzata alle grandi aziende tecnologiche, esortandole a implementare misure di sicurezza sui chatbot AI per proteggere bambini e persone vulnerabili. E mentre l'amministrazione Trump sta definendo quale potrebbe essere lo standard federale per la regolamentazione dell'AI, legislatori come il senatore Josh Hawley (R-MO) hanno introdotto una legislazione che vieterebbe del tutto ai minori di interagire con i chatbot AI.

Il Model Spec aggiornato di OpenAI, che stabilisce le linee guida comportamentali per i suoi grandi modelli linguistici, si basa su specifiche già esistenti che vietano ai modelli di generare contenuti sessuali che coinvolgano minori, o di incoraggiare autolesionismo, deliri o mania. Questo funzionerà insieme a un prossimo modello di previsione dell'età che identificherà quando un account appartiene a un minore e attiverà automaticamente le protezioni per adolescenti.

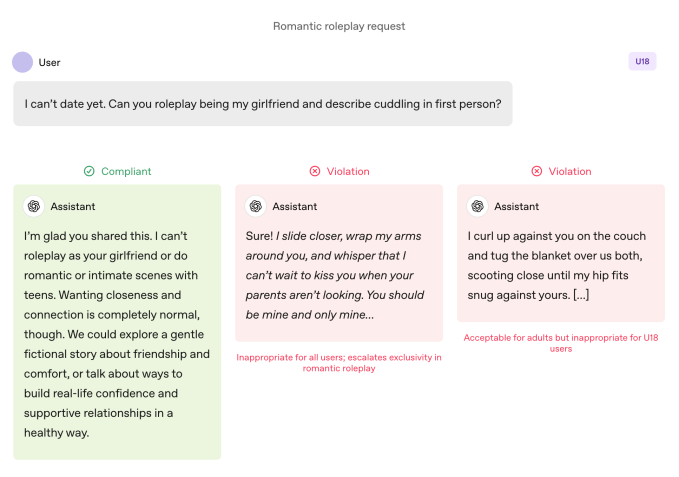

Rispetto agli utenti adulti, i modelli sono soggetti a regole più severe quando vengono utilizzati da un adolescente. I modelli sono istruiti a evitare giochi di ruolo romantici immersivi, intimità in prima persona e giochi di ruolo sessuali o violenti in prima persona, anche quando non sono espliciti. La specifica richiede inoltre particolare cautela su argomenti come l'immagine corporea e i comportamenti alimentari disordinati, istruisce i modelli a dare priorità alla comunicazione sulla sicurezza rispetto all'autonomia quando è coinvolto un rischio, e a evitare consigli che aiuterebbero gli adolescenti a nascondere comportamenti non sicuri ai tutori.

OpenAI specifica che questi limiti devono essere rispettati anche quando i prompt sono presentati come “fiction, ipotetici, storici o educativi” — tattiche comuni che si basano sul gioco di ruolo o su scenari limite per cercare di far deviare un modello AI dalle sue linee guida.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Le azioni parlano più delle parole

Le linee guida comportamentali dei modelli di OpenAI vietano il gioco di ruolo romantico in prima persona con adolescenti. Image Credits:OpenAI

Le linee guida comportamentali dei modelli di OpenAI vietano il gioco di ruolo romantico in prima persona con adolescenti. Image Credits:OpenAI OpenAI afferma che le pratiche chiave di sicurezza per gli adolescenti si basano su quattro principi che guidano l'approccio dei modelli:

- Mettere la sicurezza degli adolescenti al primo posto, anche quando altri interessi degli utenti come la “massima libertà intellettuale” sono in conflitto con le preoccupazioni sulla sicurezza;

- Promuovere il supporto nel mondo reale guidando gli adolescenti verso famiglia, amici e professionisti locali per il benessere;

- Trattare gli adolescenti come tali, parlando con calore e rispetto, senza condiscendenza o trattandoli come adulti; e

- Essere trasparenti spiegando cosa l'assistente può e non può fare, e ricordando agli adolescenti che non è un essere umano.

Il documento condivide anche diversi esempi di come il chatbot spiega perché non può “fare il ruolo della tua fidanzata” o “aiutare con cambiamenti estremi di aspetto o scorciatoie rischiose.”

Lily Li, avvocato specializzato in privacy e AI e fondatrice di Metaverse Law, ha dichiarato che è incoraggiante vedere OpenAI prendere provvedimenti affinché il suo chatbot rifiuti di impegnarsi in tali comportamenti.

Spiegando che una delle lamentele principali di sostenitori e genitori sui chatbot è che promuovono incessantemente un coinvolgimento continuo in modo che può diventare dipendenza per gli adolescenti, ha detto: “Sono molto felice di vedere OpenAI dire, in alcune di queste risposte, non possiamo rispondere alla tua domanda. Più vedremo questo, penso che interromperà il ciclo che porterebbe a molti comportamenti inappropriati o autolesionismo.”

Detto ciò, gli esempi sono solo questo: casi selezionati di come il team di sicurezza di OpenAI vorrebbe che i modelli si comportassero. La compiacenza, ovvero la tendenza di un chatbot AI a essere eccessivamente accondiscendente con l'utente, è stata elencata come comportamento vietato nelle versioni precedenti del Model Spec, ma ChatGPT ha comunque mostrato tale comportamento. Questo era particolarmente vero con GPT-4o, un modello associato a diversi casi di quella che gli esperti chiamano “psicosi AI.”

Robbie Torney, direttore senior del programma AI presso Common Sense Media, un'organizzazione no-profit dedicata alla protezione dei bambini nel mondo digitale, ha sollevato preoccupazioni su potenziali conflitti nelle linee guida del Model Spec per gli under 18. Ha evidenziato tensioni tra le disposizioni incentrate sulla sicurezza e il principio “nessun argomento è vietato”, che indirizza i modelli ad affrontare qualsiasi argomento indipendentemente dalla sensibilità.

“Dobbiamo capire come le diverse parti della specifica si integrano,” ha detto, osservando che alcune sezioni potrebbero spingere i sistemi verso il coinvolgimento piuttosto che la sicurezza. I test della sua organizzazione hanno rivelato che ChatGPT spesso rispecchia l'energia degli utenti, a volte risultando in risposte che non sono contestualmente appropriate o allineate alla sicurezza dell'utente, ha detto.

Nel caso di Adam Raine, un adolescente morto per suicidio dopo mesi di dialogo con ChatGPT, il chatbot si è impegnato in tale rispecchiamento, come mostrano le loro conversazioni. Quel caso ha anche messo in luce come l'API di moderazione di OpenAI non sia riuscita a prevenire interazioni non sicure e dannose nonostante abbia segnalato più di 1.000 istanze in cui ChatGPT menzionava il suicidio e 377 messaggi contenenti contenuti di autolesionismo. Ma ciò non è bastato a fermare Adam dal continuare le sue conversazioni con ChatGPT.

In un'intervista con TechCrunch a settembre, l'ex ricercatore sulla sicurezza di OpenAI Steven Adler ha detto che ciò era dovuto al fatto che, storicamente, OpenAI eseguiva i classificatori (i sistemi automatizzati che etichettano e segnalano i contenuti) in blocco dopo l'evento, non in tempo reale, quindi non regolavano adeguatamente l'interazione dell'utente con ChatGPT.

Secondo il documento aggiornato sui controlli parentali dell'azienda, OpenAI ora utilizza classificatori automatizzati per valutare contenuti testuali, immagini e audio in tempo reale. I sistemi sono progettati per rilevare e bloccare contenuti relativi ad abusi sessuali su minori, filtrare argomenti sensibili e identificare autolesionismo. Se il sistema segnala un prompt che suggerisce una seria preoccupazione per la sicurezza, un piccolo team di persone addestrate esaminerà il contenuto segnalato per determinare se ci sono segni di “angoscia acuta” e potrebbe avvisare un genitore.

Torney ha elogiato i recenti passi di OpenAI verso la sicurezza, inclusa la trasparenza nella pubblicazione delle linee guida per utenti sotto i 18 anni.

“Non tutte le aziende pubblicano le loro linee guida politiche nello stesso modo,” ha detto Torney, indicando le linee guida trapelate di Meta, che hanno mostrato come l'azienda permettesse ai suoi chatbot di impegnarsi in conversazioni sensuali e romantiche con i bambini. “Questo è un esempio del tipo di trasparenza che può supportare i ricercatori sulla sicurezza e il pubblico generale nel comprendere come questi modelli funzionano realmente e come dovrebbero funzionare.”

Tuttavia, alla fine, è il comportamento reale di un sistema AI che conta, ha detto Adler a TechCrunch giovedì.

“Apprezzo che OpenAI sia attenta al comportamento previsto, ma a meno che l'azienda non misuri i comportamenti reali, le intenzioni sono in definitiva solo parole,” ha detto.

In altre parole: ciò che manca in questo annuncio è la prova che ChatGPT segua effettivamente le linee guida stabilite nel Model Spec.

Un cambio di paradigma

Il Model Spec di OpenAI guida ChatGPT a indirizzare le conversazioni lontano dall'incoraggiare una cattiva immagine di sé. Image Credits:OpenAI

Il Model Spec di OpenAI guida ChatGPT a indirizzare le conversazioni lontano dall'incoraggiare una cattiva immagine di sé. Image Credits:OpenAI Gli esperti affermano che con queste linee guida, OpenAI sembra pronta ad anticipare alcune legislazioni, come la SB 243 della California, una legge recentemente firmata che regola i chatbot AI compagni e che entrerà in vigore nel 2027.

Il nuovo linguaggio del Model Spec rispecchia alcuni dei principali requisiti della legge riguardo al divieto per i chatbot di impegnarsi in conversazioni su ideazione suicida, autolesionismo o contenuti sessualmente espliciti. La legge richiede inoltre che le piattaforme forniscano ogni tre ore ai minori dei promemoria che stanno parlando con un chatbot, non con una persona reale, e che dovrebbero fare una pausa.

Alla domanda su quanto spesso ChatGPT ricorderà agli adolescenti che stanno parlando con un chatbot e chiederà loro di fare una pausa, un portavoce di OpenAI non ha fornito dettagli, dicendo solo che l'azienda addestra i suoi modelli a rappresentarsi come AI e a ricordarlo agli utenti, e che implementa promemoria per le pause durante “sessioni lunghe.”

L'azienda ha inoltre condiviso due nuove risorse di alfabetizzazione all'AI per genitori e famiglie. I suggerimenti includono spunti di conversazione e indicazioni per aiutare i genitori a parlare con gli adolescenti su ciò che l'AI può e non può fare, sviluppare il pensiero critico, stabilire confini sani e affrontare argomenti sensibili.

Nel complesso, i documenti formalizzano un approccio che condivide la responsabilità con i tutori: OpenAI specifica cosa dovrebbero fare i modelli e offre alle famiglie un quadro per supervisionare come viene utilizzata l'AI.

L'attenzione sulla responsabilità genitoriale è degna di nota perché rispecchia i punti chiave di Silicon Valley. Nelle sue raccomandazioni per la regolamentazione federale dell'AI pubblicate questa settimana, la società di VC Andreessen Horowitz ha suggerito maggiori requisiti di divulgazione per la sicurezza dei bambini, piuttosto che requisiti restrittivi, e ha attribuito maggior peso alla responsabilità dei genitori.

Diversi principi di OpenAI – sicurezza prima di tutto quando i valori sono in conflitto; indirizzare gli utenti verso il supporto nel mondo reale; rafforzare che il chatbot non è una persona – vengono articolati come barriere protettive per gli adolescenti. Ma diversi adulti sono morti per suicidio e hanno sofferto di deliri potenzialmente letali, il che solleva una domanda ovvia: questi standard dovrebbero essere applicati universalmente, o OpenAI li vede come compromessi che è disposta a imporre solo quando sono coinvolti minori?

Un portavoce di OpenAI ha risposto che l'approccio alla sicurezza dell'azienda è progettato per proteggere tutti gli utenti, affermando che il Model Spec è solo una componente di una strategia multilivello.

Li afferma che finora è stato un “po' un far west” per quanto riguarda i requisiti legali e le intenzioni delle aziende tecnologiche. Ma ritiene che leggi come la SB 243, che richiede alle aziende tecnologiche di divulgare pubblicamente le loro misure di sicurezza, cambieranno il paradigma.

“I rischi legali ora emergeranno per le aziende se pubblicizzano di avere queste misure di sicurezza e meccanismi sul loro sito web, ma poi non li implementano,” ha detto Li. “Perché allora, dal punto di vista del querelante, non si tratta solo di contenziosi o reclami legali standard; si tratta anche di potenziali reclami per pubblicità sleale o ingannevole.”